¿Sabías que las células de nuestro cuerpo saben cuándo es de día y cuándo es de noche? Este fenómeno se llama “ritmo circadiano” y es de gran importancia para regular desde procesos a nivel celular hasta el comportamiento de los seres vivos.

De cuentos y patas, un blog para bicharrajos

De cuentos y patas, un blog para bicharrajos

Bichos, alimañas, sabandijas. Bien reza el dicho, "más sabe el diablo por viejo que por diablo". A la luz de la historia biológica de la tierra, pocos grupos de animales podrán presumir de ser tan sabios como aquel de los artrópodos. Son por mucho el grupo de animales más numeroso en especies, y de los más antiguos

Bacterias y hongos produciendo mi detergente

No todas las bacterias y hongos causan enfermedades o plagas como a veces se suele creer; con ayuda de la biotecnología y de la ingeniería genética podemos hacer uso de algunas moléculas que ellos utilizan como las enzimas. Pero, ¿qué son las enzimas? Son herramientas que todos los seres vivos producen y que ayudan a que los procesos que tienen lugar dentro de las células se lleven a cabo más rápido, ya sea degradando o sintetizando compuestos que posteriormente serán utilizados. Gracias a la biotecnología, se ha logrado manipular muchas enzimas con el fin de obtener o mejorar productos, como por ejemplo los detergentes. Imaginemos ahora el mecanismo de limpieza de un detergente común. Un detergente es una mezcla de compuestos que facilita la remoción de suciedad en las telas; dado que el agua por sí sola no es capaz de penetrar en las telas con suciedad, al combinarse con el detergente se facilita la absorción en la ropa. Esto es gracias a que los detergentes disminuyen la tensión superficial del agua. Una vez absorbido, el detergente comienza su mecanismo de limpieza gracias a unas estructuras llamadas “micelas”, las cuales son pequeñas cápsulas que atrapan la suciedad liberándola a la superficie.

Las enzimas en los detergentes se utilizan para romper enlaces de biomoléculas como lípidos, carbohidratos y proteínas, causantes de manchas casi imposibles de eliminar. La eficiencia de las enzimas llega a tal alcance que gracias a estos nuevos productos biotecnológicos el eliminar manchas de sangre, aceite y otras que antes condenaban a las prendas a la basura, ahora se ha vuelto una tarea más sencilla y esto gracias a aquellos microorganismos que tanto nos desagradan.

Existe una gran cantidad de bacterias y hongos cuyas enzimas inspiran nuevos productos biotecnológicos, un ejemplo de algunos son las bacterias Bacillus lichenformis y Bacillus amyloliquefaciens, y los hongos Humicola insolens, Aspergillus oryzae y Aspergillus flavus. Todos estos son utilizados en la industria biotecnológica en los detergentes con enzimas.

La Bacillus lichenformis es una bacteria encontrada en forma de espora en el suelo. De ella se obtienen las “amilasas”, específicamente la α-amilasa, que es una enzima que ayuda a degradar residuos de almidones o carbohidratos, como el chocolate o las harinas.

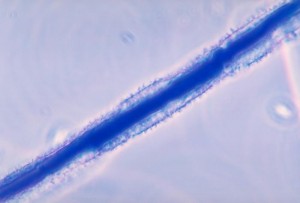

La Bacillus amyloliquefaciens, por otro lado, es una bacteria productora de las enzimas llamadas “proteasas”, las cuales se encargan de romper, con ayuda del agua, los enlaces que unen a las proteínas, removiendo manchas de huevo y sangre, ambos constituidos principalmente por este tipo de macromoléculas. Estas proteasas son también producidas por el hongo Aspergillus flavus (figura 1), causante de enfermedades en humanos; puede ocasionar desde una rinitis alérgica hasta asma crónica severa. Este tipo de hongo forma filamentos o ramificaciones durante su crecimiento, secretando la enzima capaz de descomponer alimentos complejos. Este tipo de enzimas se encargan de romper las proteínas en las moléculas que la constituyen, o sea los aminoácidos, pues así el hongo puede alimentarse fácilmente.

Figura 1. Aspergillus flavus, hongo que causa enfermedades en humanos, pero cuyas enzimas también han sido útiles para la producción de detergentes. Imagen cortesía del Dr. Libero Ajello , ID #4299.

Otras enzimas integradas en los detergentes son las “lipasas”, que ayudan a disolver las manchas de grasas y aceites en la ropa, y son producidas por un hongo filamentoso llamado Humicola. Mediante la biotecnología se logró aislar el gen de la lipasa de este hongo y se transfirió al hongo Aspergillus oryzae, utilizado también en la producción de salsa de soja mediante la fermentación.

Todas estas enzimas son muy eficientes en nuestra ropa hecha de algodón, compuesto en un 91.5% de celulosa, un tipo de carbohidrato complejo que forma las fibras que se entrelazan para crear una tela. Al desgastarse la tela, se exponen cada vez más fibras de algodón al exterior promoviendo la pérdida de color y la apariencia desgastada en la ropa. Actualmente los detergentes que conservan el color en las telas contienen “celulasas” que son extraídas de un hongo llamado Humicola insolens. Estas enzimas están encargadas de degradar la celulosa contenida en las fibras de algodón desgastado, así se pierden los excedentes causantes del color opaco y se restaura el color original de la prenda.

Gracias a la biotecnología podemos manipular bacterias y hongos que en otras circunstancias resultan perjudiciales para nuestra salud y utilizarlas para nuestro beneficio en asuntos de la vida diaria. Estas innovaciones se apoyan en dichos microorganismos para que los procesos industriales se vuelvan amigables con el ambiente, permitiéndonos crear productos biodegradables de uso cotidiano tales como los detergentes.

Referencias

Jesús Córdoba López, S. R. (s.f.). Producción de Lipasas de hongos termófilos cultivados en medios líquidos y sólidos. Guadalajara, Jalisco, México.

Jorge Gonzáles-Bacerio, V. R.-M.-M. (2010). Las lipasas: enzimas con potencial para el desarrollo de biocatalizadores inmovilizados por adsorción interfacial. Revista Colombiana de Biotecnología , 12 (1).

Jyoti Vakhlu, A. K. (10 de Agosto de 2005). Yeast Lipases: enzyme purification, biochemical properties and gene cloning. 9(1). Electronic Journal of biotechnology.

Murray, P. (2009). Center for Integrated Fungal Reaserch. Obtenido de AspergillusFlavus.org: http://aspergillusflavus.org/aflavus/

Las enzimas en los jabones para la ropa. Recuperado el 24 de noviembre del 2014 desde http://www.argenbio.org/index.php?action=novedades¬e=240

Proteasa. Recuperado el 24 de noviembre del 2014 desde http://www.ecured.cu/index.php/Proteasa

Martínez G., J.F. (2005). Utilización de la α-amilasas en la formulación de detergentes industriales. Tesis doctoral, Departamento de ciencias químicas, Universidad de Granada.

Agradecimientos

A la Dra. Yalbi I Balderas-Martínez de la Facultad de Ciencias, UNAM, México, D.F. por la revisión del escrito.

Autores

Estudiantes de la Ing. en Biotecnología de la Universidad Politécnica del Estado de Morelos UPEMOR. Por orden alfabético:

Alejandra Naomi Adán Valencia, Sergio A. Chavarría Santibañez, Emmanuel Gómez Corona, Gabriela Hernández Contreras, Oliver Gerardo Moreno Aguilera, Karen Azucena Ruiz Guerrero, Jonathan Sandoval Espinoza.

Una breve historia del petróleo y la sociedad que decidió explotarlo

Hace algunos meses un grupo de hackers de la comunidad musulmana, bajo el nombre de AnonGhost, lanzó el primero de lo que prometió sería una serie de ataques contra corporaciones occidentales y ciertos gobiernos de países árabes; la campaña #OpPetrol es un ataque dirigido a la industria petrolera que, en palabras de los activistas, “ha deshumanizado la economía y ha creado un nuevo orden mundial basado en el Petro Dólar”. Del otro lado del mundo, un grupo de ecologistas es arrestado por protestar contra la construcción de las primeras minas para explotar arenas de petróleo en Estados Unidos que, siguiendo el ejemplo de Canadá, busca extraer hidrocarburos por vías poco ortodoxas, como respuesta al agotamiento de otro tipo de yacimientos.

En México se invierten cantidades exorbitantes en la exploración y explotación de yacimientos petroleros en aguas profundas aún cuando la sombra del desastre provocado por el hundimiento de la plataforma Deepwater Horizon en 2010 no se ha disipado del todo.

No cabe duda que el mundo se mueve con combustibles fósiles y es un hecho que la reserva mundial de estos hidrocarburos está menguando; día con día somos testigos de las implicaciones políticas, económicas y sociales que se desprenden de este hecho. Pero, ¿qué sabemos realmente del petróleo?, ¿de dónde viene?, ¿cuándo comenzamos a explotarlo?, ¿por qué parece haber tan poco? y ¿cómo pasó de ser una solución energética a ser un problema mundial? Para darle respuesta a estas preguntas tenemos que comenzar el relato hace algunos millones de años, cuando la Tierra era muy diferente a lo que conocemos ahora.

Un puré de microorganismos a presión

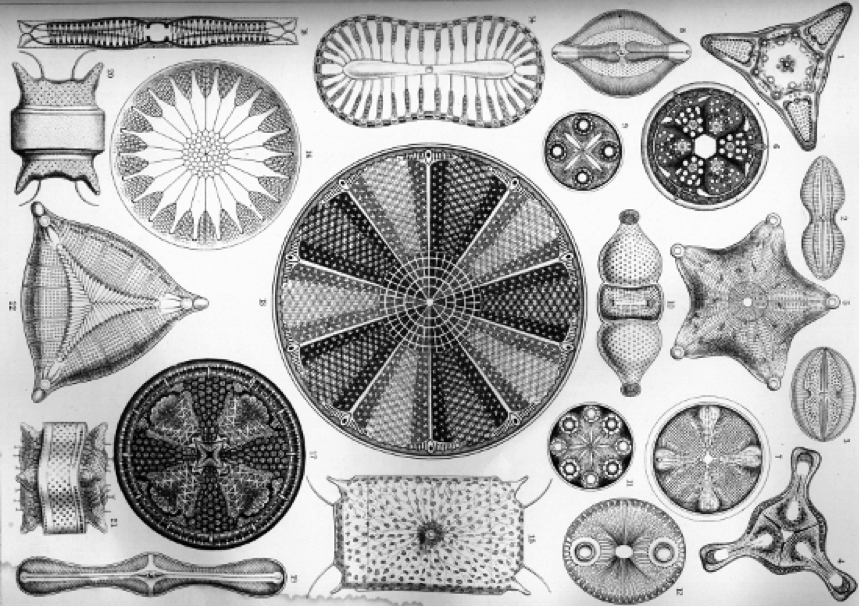

Contrario a la creencia popular, hay muy poco de dinosaurios en nuestro petróleo; la mayor parte de él tuvo su origen en las aguas tibias y someras de mares antiguos, donde las condiciones ambientales favorecieron una explosión de vida microscópica (algas verde azules, foraminíferos y diatomeas), pero un océano floreciente de vida es también un océano lleno de muerte; cuando estos microorganismos partían al cielo de las diatomeas, sus restos se depositaron por millones sobre el lecho marino; en ocasiones la velocidad de este proceso era tal, que el piso oceánico acumulaba restos con mayor velocidad que la necesaria para iniciar el proceso de descomposición. A esta receta sólo tenemos que agregarle unos cuantos millones de años de temperatura y presión elevadas y listo: nuestro coctel de microorganismos se ha transformado en petróleo.

Las condiciones adecuadas para la formación de petróleo no son exclusivas de una era geológica; distintas circunstancias pudieron haber generado situaciones similares a las expuestas anteriormente para formar los yacimientos que tanto nos esforzamos en localizar hoy en día. Un elemento constante para que sea exitosa la transformación del plancton en un potencial combustible de avión, es el paso del tiempo. Las condiciones de temperatura y presión necesarias para que esto suceda se logran mediante la acumulación lenta y sostenida de sedimentos que aumentan gradualmente la presión de las capas más bajas y provocan que éstas eleven su temperatura al estar más cerca del manto terrestre. Esto sólo sucede con el paso de millones y millones de años. En este proceso, además de petróleo, también se genera gas natural.

El carbón, el tercer elemento en nuestro imperio de combustibles fósiles, se generó mediante un proceso similar, pero éste utilizó materia vegetal “macro” -troncos y ramas- como materia prima. Estudios recientes han sugerido que la abundancia de depósitos de carbón con más de trescientos millones de años de antigüedad puede estar relacionada con la ausencia de hongos capaces de descomponer la lignina de los troncos. ¿De qué sirve comer madera si no se ha “inventado” la madera aún?

Existe un teoría alternativa respecto a la formación de petróleo y otros combustibles fósiles por la descomposición de materia viva: la teoría abiótica. Los defensores de esta teoría argumentan que el origen del petróleo, el carbón y el gas natural podrían estar ligados a procesos que ocurren naturalmente en las capas más profundas de la corteza terrestre, cerca del manto, sin necesidad de la intervención de materia viva. Existe una gran controversia con respecto a esta teoría, pero no puede eliminarse debido al simple hecho de que nadie ha presenciado la formación de petróleo de forma natural. Si la teoría abiótica tuviera fundamentos, esto implicaría que existe más –mucho más- petróleo, gas y carbón en la Tierra del que tenemos previsto; sin embargo, esto también implica que dichos recursos podrían estar a profundidades y condiciones tales que su explotación es prácticamente inviable bajo los esquemas de extracción actuales. Independientemente de quién tenga la razón, en términos de aprovechamiento de recursos, quedamos en las mismas.

El surgimiento de una economía petrolera

El petróleo se ha utilizado de forma más o menos constante por varias civilizaciones humanas. Existen registros de su uso por griegos, chinos y persas, quienes utilizaban el recurso para labores de construcción y, por su carácter inflamable, como materia prima para lámparas y otras pirotecnias. Su historia moderna empieza a mediados del siglo XIX, cuando pasó de ser un remedio casero para curar dolores reumáticos a ser el principal combustible utilizado en la iluminación.

El queroseno –un aceite producido a partir de una destilación simple del petróleo- sustituyó rápidamente al aceite de ballena como principal fuente de iluminación, debido a su bajo costo y aparente abundancia; esta industria fundamenta el éxito temprano de la explotación petrolera. Pronto se comenzaron a construir refinerías a gran escala para solucionar la demanda del combustible y procesar el nuevo recurso que “brotaba de la tierra”. John D. Rockefeller aprovechó la fiebre del oro negro y fundó Standard Oil, la compañía que capitalizó el aprovechamiento del hidrocarburo hasta principios del siglo XX.

En 1879 Thomas Alva Edison presenta al mundo el primer foco de luz incandescente, capaz de comercializarse a gran escala y el imperio del queroseno llega a su fin. Sin embargo, los procesos de refinación petrolera habían generado un sinnúmero de productos aprovechables y el petróleo no tardó en encontrar un nuevo mejor amigo: el motor de combustión interna.

A partir de aquí, la historia es fácil de recapitular: Henry Ford hace que el motor de combustión interna se vuelva uno de los bienes más comunes en los hogares estadounidenses y en el mundo, la demanda mundial de petróleo aumenta exponencialmente durante el siglo XX y se empiezan a aprovechar nuevos subproductos de la refinación del petróleo crudo, principalmente en la forma de polímeros plásticos.

Los primeros síntomas de agotamiento se hacen evidentes y para los años sesenta, Estados Unidos no puede sostener una producción capaz de satisfacer la demanda y se convierte en un fuerte importador del hidrocarburo. El mismo destino aqueja a muchos países industrializados y los conflictos bélicos por el recurso limitante empiezan a hacerse evidentes.

El petróleo hoy

El panorama actual no es muy alentador. Existen fuentes muy optimistas y otras muy pesimistas sobre la cantidad de combustibles fósiles que quedan a nuestra disposición, pero la realidad es que el acceso a estos recursos, independientemente de la cantidad que quede, es cada vez más difícil y costoso. Prácticas altamente cuestionadas por sus repercusiones ambientales como el fracking y la explotación de arenas bituminosas ocupan las primeras planas en muchos países. A estos problemas, es necesario sumar que el aprovechamiento de combustibles fósiles es, en buena parte, responsable de los problemas de contaminación prevalecientes en las ciudades modernas y la mayor fuente de los gases invernadero de origen antropogénico que juegan un papel importante en el cambio climático. La época en la que el petróleo brotaba de la tierra sin mayores consecuencias ha quedado atrás.

Mientras muchos países siguen discutiendo medidas sobre cómo mantener las políticas energéticas vigentes, otros como Dinamarca han puesto manos a la obra en la búsqueda de alternativas. Dinamarca planea sustentar 70% del consumo energético nacional con recursos renovables (mediante el aprovechamiento de energía eólica) para 2020 y ser totalmente sustentable para mediados de siglo.

Basar la economía global, de un país o de un pueblo en recursos no renovables no es una buena inversión a largo plazo. Quiero cerrar este artículo contándoles la historia de Pithole City, Pennsylvania; esta ciudad se estableció en 1965, en medio de la fiebre petrolera estadounidense. A unos meses de haberse realizado el trazo urbano, ya contaba con la oficina de correos más grande del estado, más de cincuenta hoteles, un periódico propio y una población superior a los quince mil habitantes. La producción petrolera que enriqueció a muchos de los habitantes de la ciudad cayó más de 70% en menos de un año y para 1977 la ciudad estaba completamente abandonada. Hoy, Pithole City prevalece como un museo donde se puede admirar la historia de los primeros días de la industria petrolera americana.

Si quieren conocer más detalles sobre la industrial petrolera, la historia del petróleo y los procesos químicos detrás de su refinación y aprovechamiento, aquí les dejó un link al libro Petroquímica y Sociedad de Susana Chow Pangtay. Si quieren algo más de información sobre el mercado y la situación global de la industria petrolera les recomiendo el libro Oil 101 de Morgan Downey. Y si quieren una buena lectura en el contexto del nacimiento de la industria petrolera americana, échenle un ojo a Oil! De Upton Sinclair o a su adaptación cinematográfica por Paul Thomas Anderson There Will Be Blood. ¡Ambos son muy recomendables!

Imitando a la Naturaleza: Diseño Molecular de un Virus

Cuando se inicia una nueva investigación uno nunca sabe que tan lejos podrá llegar, aunque uno supone que no tan lejos porque suele pasar que en ciencia uno va caminando muy lentamente. Pocos son los que han encontrado en su investigación la rendija que los llevará al otro lado, ese lado tan anhelado pero poco visitado. Eso es lo que pensaba hasta hace unos meses cuando los resultados de mi investigación empezaron a mostrar que el tiro por el que apostamos dio al blanco y así lo confirmaban experimentos sucesivos. La Composición Determina La Función

Empezaré explicando lo básico. Como todos saben toda la materia está hecha de átomos y moléculas y dependiendo de cómo estén arreglados en el espacio y tiempo es como serán sus propiedades. Esto también aplica para la materia biológica, la que está compuesta de biomoléculas, ya sabes, proteínas, ácidos nucleicos (ADN o ARN), lípidos y carbohidratos. La materia biológica también está ordenada en el espacio y tiempo aunque, no está de más decirlo, particularmente de manera muy precisa y compleja. Me detendré a explicar con más detalle este dato que es sumamente importante. Debido a su carácter polimérico1, las biomoléculas forman estructuras regulares; esto significa que despliegan ciertos grupos químicos con orientación espacial fija, lo cual condiciona las interacciones que establecen con otras biomoléculas tanto en el tiempo y espacio y, por lo tanto, las propiedades de esa biomolécula en particular están determinadas. Por interacciones me refiero a fuerzas de atracción o repulsión hacia otros grupos químicos desplegados por otras (bio)moléculas, incluyendo las moléculas de agua. Todo esto depende en última estancia de la composición particular de la biomolécula. Es decir la composición de las biomoléculas codifica para su funcionalidad. Así es que conociendo la composición de una biomolécula en particular y sabiendo como se despliega en el espacio es posible predecir y modificar sus propiedades, o bien crear una biomolécula desde cero o de novo con ciertas propiedades. Esto es uno de los paradigmas más importantes de la química actual, es el engranaje que mueve la maquinaria de la (bio)nanotecnología. Se puede intuir la gran capacidad que tiene para revolucionar el estado actual de la tecnología.

Esta impresionante capacidad actual de la química es resultado de las pasadas décadas de estudio intensivo y acelerado de las propiedades básicas de la (bio)materia y de entender sus interacciones, desarrollar modelos para cuantificarlas y poder predecir sus efectos. A la par, han llegado otros desarrollos tecnológicos que permiten un rápido estudio de la ingeniería biomolecular, microscopios de fuerza atómica (que permiten ver y manipular átomos y moléculas individuales), de fluorescencia (entender interacciones y dinámicas), estandarización de métodos de biología molecular (para poder producir cualquier proteína exista o no en la naturaleza).

Diseñando (Bio)Moléculas Con Propiedades Específicas

Con esta capacidad para predecir las propiedades de nuevas (bio)moléculas los científicos hemos empezado a preguntarnos: ¿podemos diseñar (bio)moléculas que puedan imitar estructuras de la naturaleza tales como las encontradas en la fotosíntesis (para obtención de energía), o las capsulas virales (para tener sistemas de entrega de medicamentos mucho más eficientes) y usarlas para nuestro beneficio? La respuesta es sí.

Diseñando Partículas Virales Artificiales

Cuando inicié mi proyecto de doctorado mis supervisores me decían que no teníamos necesariamente que lograr lo que estaba planteado por escrito en la propuesta de anteproyecto, que usualmente, aunque se tiene como objetivo, no se alcanza. Bien, si la naturaleza ya lo ha logrado, ¿por qué no usarla como fuente de inspiración?

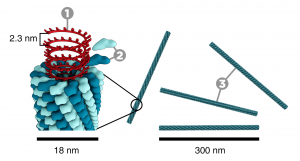

Si tomamos un virus muy sencillo, como el virus del mosaico del tabaco (VMT) y analizamos sus componentes, podemos distinguir que está compuesto por una sola molécula de ARN recubierta por alrededor de 2000 copias de una proteína, formando una estructura alargada de aproximadamente 300 nanómetros (parecen rodillos rígidos) donde el ARN se encuentra en el interior (ver figura 1). Parece ser que la cápsula (el recubrimiento) es bastante sencilla, solo un tipo de proteína que se ordena alrededor del ARN. ¿Como está diseñada esta proteína que al mezclarla con el ARN forma espontáneamente estructuras regulares capaces de infectar células de las hojas del tabaco? Como se pueden dar cuenta, el diseño mínimo de una partícula viral recae en el diseño de la cubierta proteínica, ya que básicamente ella realiza todas las funciones esenciales.

Figura 1. Virus del Mosaico del Tabaco (VMT). 1) ARN 2) Sub-unidad proteínica de la cubierta 3) Partículas virales ensambladas (Crédito de la imagen: Splette)

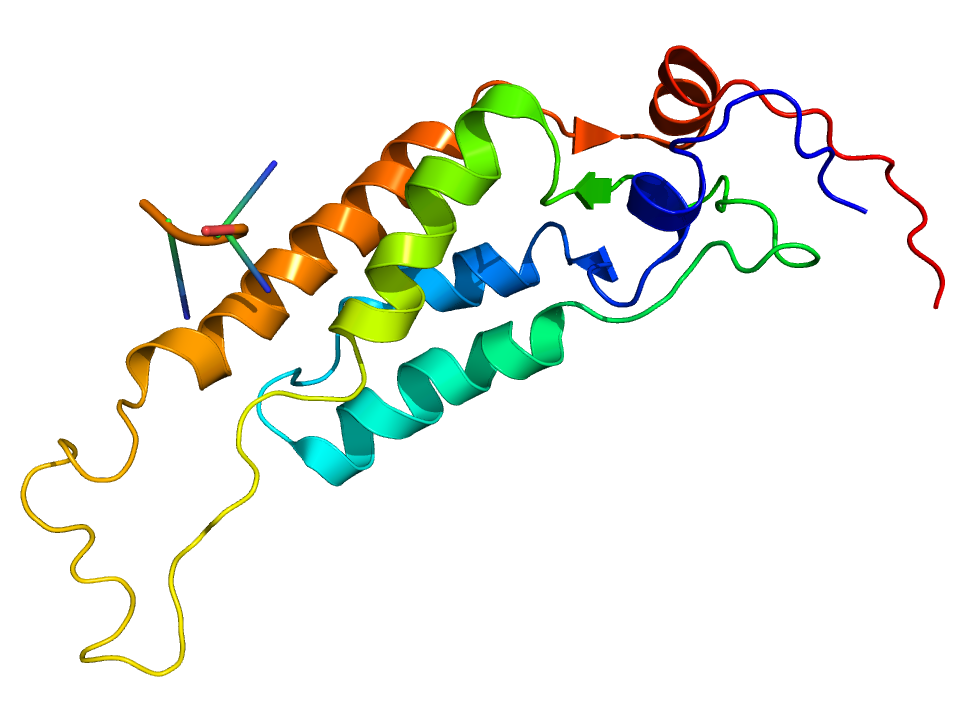

Si analizamos la proteína de la cubierta del virus podemos distinguir partes de ella que realizan funciones fundamentales (ver figura 2), 1) unión al ácido nucleico (ARN), 2) Auto-ensamblaje alrededor del ARN (establece interacciones entre proteínas adyacentes de manera coordinada y ordenada) 3) Estabilidad coloidal (evita que partículas virales ya formadas empiecen a agregarse entre sí o se insolubilicen, ya que partículas grandes tienden a precipitarse en solución).

Figura 2. Sub-unidad proteica de la cubierta del virus del mosaico del tabaco

Codificando La Funcionalidad En La Composición Química

¿Cómo codificar estas funciones a nivel molecular en proteínas artificiales? Imitando la química de los virus. Si se toma una secuencia de aminoácidos (de lo que están hechas las proteínas) con alta densidad de carga positiva entonces se podrán unir a los ácidos nucleicos que son negativos. Si se une a esta otra secuencia con propiedades de auto-ensamblado entonces podrás dirigir la condensación del ácido nucleico en estructuras alongadas de forma cooperativa. La propiedad de auto-ensamblado es fundamental para hacer emerger la cooperatividad, propiedad que es ubicua en todos los sistemas biológicos y que asegurará que las partículas entre el ARN y la proteína estén ensambladas completamente y por lo tanto la información genética del ácido nucleico esté protegida. La última función requerida es la estabilidad coloidal que se puede lograr si se añade una secuencia de aminoácidos que den solubilidad al agregado. Estas propiedades permitirán que las partículas penetren las células y entreguen el cargamento de ADN. No está de más decir que una partícula viral artificial formada de esta forma es totalmente segura ya que no es capaz de replicarse e infectar nuevas células ya que esas funciones no están codificadas en la cubierta diseñada.

Después de una larga labor produciendo estas proteínas, en una de esas noches largas que pasarán a la posteridad, sentado enfrente del microscopio vislumbre una imagen increíble, una serie de estructuras alargadas esparcidas por la superficie. Eran mis partículas virales con las que habíamos soñado años antes. Unos minutos antes había mezclado un poco de ADN con cierta cantidad de mi proteína diseñada. Las proteínas que diseñamos habían empezado su danza microscópica, cual historia de amor, habían sido atraídas por ese aroma negativo del ADN, y empezado a recubrirlo. Una parte de ellas , responsable del auto-ensamblado, les ordenó a todas esas proteínas reunidas alrededor del ADN actuar, condensar el ADN en una pequeña partícula de 300 nm, rígida, alargada como una fibra. Acercamiento. Esto es un virus, una partícula viral artificial, una molécula de ADN condensada por una cubierta proteínica diseñada por nosotros. La danza molecular ha terminado, ahora yo danzo, brinco y grito de emoción. ¿Hasta dónde llegará esto? Semanas después colaboradores del Centro Médico de Nimega nos confirman, esas partículas han logrado entrar a células y entregar el ADN que expresa una proteína fluorescente. Después llegaron los teóricos de la Universidad de Eindhoven y nos cuentan que el proceso físico de ensamblaje es similar al del virus del mosaico del tabaco, nuestra fuente de inspiración.

Este estudio ha demostrado que es posible codificar en diferentes secuencias las mismas funcionalidades que se requieren para crear algún material que imite a componentes biológicos. De una forma es imitar la nanotecnología de la naturaleza. El diseño de moléculas funcionales que se auto-ensamblen en nuevos materiales con propiedades controladas a la escala nanométrica ya es una realidad. El siguiente paso es ahora empezar a crear otros materiales que imiten a la naturaleza de una manera mas compleja, ensambladores de nanomateriales, sensores ultra potentes, captadores de energía solar, cápsulas que respondan a estímulos del cuerpo para que combatan una enfermedad, etc. Las perspectivas son amplias para las partículas virales diseñadas de novo. Se pueden añadir secuencias con función de reconocimiento de células enfermas (por ejemplo, cáncer) para que sean usadas para terapia génica o para entregar otros ARN de interferencia afectando mínimamente al tejido sano. También pueden ser usados para crear vacunas de diseño.

En Hombros De Gigantes

En este punto me pongo a reflexionar sobre todos esos hombres y mujeres que desde hace décadas han contribuido a entender los componentes celulares, no solo para aplicar su conocimiento sino para entender lo que somos, y que con sus contribuciones han cimentado nuestro trabajo actual: podemos diseñar moléculas con un refinamiento tal que imiten a las máquinas moleculares de la naturaleza.2

Si tienes cualquier comentario, sugerencia o pregunta no dudes en dejarla. Gracias por tu atención.

Notas

1. Un polímero es una molécula muy grande formada por múltiples repeticiones de una unidad básica.

2. Si bien la célula no es en esencia una máquina, visualizarla como tal en ciertas ocasiones trae resultados muy prácticos y espectaculares

Escrito por Armando Hernández y publicado originalmente en su blog acerca de bionanotecnología

[hozbreak]

Acerca del autor

La Bionanotecnología y sus conceptos

El vertiginoso desarrollo de la ciencia ha logrado avances impresionantes que necesitan ser divulgados entre la sociedad. Entre las nuevas fascinaciones de las mujeres y hombres de ciencia se encuentra la Bionanotecnología o también llamada Ingeniería Biomolecular, que destaca tanto por sus aportaciones a la ciencia e incidencia en el desarrollo tecnológico como por su carácter altamente interdisciplinario y polifacético donde convergen diferentes enfoques provenientes de la biología, química, física e ingeniería.

¿Qué es la bionanotecnología?

La bionanotecnología se origina de la fusión entre la nanotecnología y la biotecnología. Por un lado, la nanotecnología es la construcción y modelaje de la materia manipulando átomo por átomo aplicada en la ingeniería y manufactura a escala nanométrica. Por el otro, la biotecnología aprovecha diversas funcionalidades derivadas de procesos biológicos para aplicaciones específicas sin que importen los detalles moleculares y atómicos de las biomoléculas que llevan a cabo dichos procesos. Con base en ello, la bionanotecnología se define como la ingeniería y manufactura aplicada al diseño y modificación de los detalles atómicos de maquinarias y dispositivos moleculares basados en biomoléculas (ácido desoxirribonucleico -ADN-, proteínas, lípidos y carbohidratos) para que lleven a cabo funciones especificas a nivel nanométrico construidos mediante ensambladores biomoleculares. El rápido avance científico hace que el ámbito de influencia de la bionanotecnología aun se esté definiendo.

Para tener idea de las dimensiones de dichas máquinas es necesario decir que un nanómetro es la milmillonésima parte de un metro, o bien en nuestro mundo macroscópico equivaldría a comparar una moneda con el ¡diámetro de la tierra! La capacidad de visualización y manipulación de diminutos átomos y moléculas se logra con instrumentos y técnicas sofisticadas y refinadas de microscopía, cristalografía, espectroscopia y modelaje en computadora.

Las biomoléculas son las protagonistas

Las biomoléculas son los componentes de la célula desarrollados y optimizados a través de millones de años de evolución natural que mantienen la vida celular llevando a cabo todas las funciones necesarias para su crecimiento, sobrevivencia y reproducción.

A pesar de que la célula es un sistema altamente complejo, base de la vida, se puede hacer una analogía (muy pobre, pero muy efectiva) con una máquina o un sistema compuesto de varias máquinas. Por ejemplo, el flagelo bacteriano y el complejo ATP sintasa funcionan esencialmente como motores generando movimiento mecánico alrededor de un eje y bombeando protones, mientras que la miosina realiza la contracción muscular; los anticuerpos y receptores de membrana detectan diversas moléculas por lo que son sensores; la actina y los microtúbulos son vigas y soportes, las enzimas son herramientas reparadoras y constructoras, los ribosomas son los ensambladores que construyen nuevas máquinas proteínicas en líneas de producción, el ADN es el control numérico, los lípidos forman vesículas contenedoras y la membrana lipídica que rodea la célula tal como si fuera una carcasa, etcétera. Todas estas entidades biológicas son delicadas moléculas de tamaño nanométrico con propiedades basadas principalmente en la química y debido a que en esencia realizan funciones de máquinas con precisión atómica también pueden ser caracterizadas y optimizadas con enfoques de la física y la ingeniería.

La célula crea las biomoléculas

Debido a que las biomoléculas son productos exclusivos del metabolismo celular, el desarrollo de la biología molecular en las últimas décadas ha sido de gran ayuda para la bionanotecnología permitiendo conocer los detalles de los mecanismos de muchas de estas “nanomáquinas”.

De inmensa importancia ha sido el desarrollo de la tecnología del ADN recombinante en la expansión de la bionanotecnología ya que ha permitido modificar y producir en gran escala de forma barata y rápida las “bionanomáquinas” y biomateriales necesarios para la bionanotecnología. Como el ADN posee toda la información necesaria para generar una proteína funcional (la gran mayoría de las “bionanomáquinas” están compuestas de proteína), es decir, contiene secuencias de ácidos nucleicos que codifican para los aminoácidos de una proteína, solo basta alterar y editar las secuencias del ADN para modificar una proteína particular con precisión atómica y así optimizar su funcionamiento y propiedades o generar nuevas y novedosas máquinas de proteína, las cuales son producidas en gran cantidad a partir de substratos baratos al crecer la célula con el gen en particular. La capacidad de manipular la célula es sin duda un cambio de paradigma que ha revolucionado tanto la ciencia como la forma en que vemos al mundo.

La Bionanotecnología trabaja interdisciplinariamente

Además de optimizar y modificar las biomoléculas a escala nanométrica para aplicaciones específicas, la bionanotecnología se ha adentrado en nuevos caminos y consolidado como un área altamente interdisciplinaria. Fusionándose con la ciencia de materiales ha desarrollado novedosos materiales híbridos entre compuestos inorgánicos y bioorgánicos, superando así la tradicional separación entre estos dos tipos de materia y borrando las fronteras entre la materia viva e inanimada.

Esta área usa proteínas y ácidos nucleicos como unidades programables de reconocimiento molecular, las cuales son acopladas (ligadas químicamente) a nanopartículas inorgánicas con propiedades ópticas, electrónicas y catalíticas diversas e interesantes, útiles para elaborar materiales y dispositivos inteligentes basados en compuestos híbridos que se auto-ensamblan en complejos supramoleculares nanométricos usados en aplicaciones bioanalíticas y biomédicas para diagnóstico, visualización y tratamiento de enfermedades y también para computación, electrónica, óptica y manufactura molecular.

Borrando Fronteras entre la Materia

El punto cardinal en la Bionanotecnología es la materia y la disolución de la frontera bioorgánica/inorgánica. Objetos vivos e inanimados están hechos por átomos. Las propiedades de la materia cambian de acuerdo con el patrón en que estén ordenados y enlazados los diferentes átomos que la componen: carbón y diamante, arena y chips de computadora, cáncer y tejido sano, tienen cierta disposición que hace la diferencia entre lo enfermo de lo sano y lo barato de lo valioso, tal como dice el apóstol de la nanotecnología, Erik Drexler en su famoso libro Máquinas de creación.

Hemos entrado en la era conjunta de la manipulación atómica y genética. Hay muchos riesgos pero también mucho potencial, que bien balanceado y en un ambiente democrático puede ser aprovechado para atender problemáticas específicas dentro del contexto mexicano.

Así, los bionanotecnólogos han creado nuevos horizontes en la ciencia, han descubierto excitantes áreas de desarrollo tecnológico y científico, novedosas e inéditas aplicaciones de las biomoléculas y han generado hitos de interdisciplinariedad al asociar disciplinas comúnmente separadas. La pregunta es, parafraseando al Nobel Richard Feynman en su discurso inaugural de la nanotecnología, ¿habrá suficiente espacio en el fondo de nuestra mente para apoyar la bionanotecnología en México?

Escrito por Armando Hernández y publicado originalmente en su blog acerca de bionanotecnología

[hozbreak]

Acerca del autor

Epistemología: filosofía de/en/desde/con/para la ciencia

En su célebre conferencia de 1957 (convertida después en el último capítulo del libro La ciencia, su método y su filosofía) titulada "Filosofar científicamente y encarar la ciencia filosóficamente", el epistemólogo Mario Bunge le cuenta a sus alumnos (tanto de aquel tiempo como los que ahora lo leemos) la necesidad urgente de generar epistemólogos de primer nivel en Latinoamérica, con el fin de incrementar la difusión y el estudio de los fundamentos de la ciencia, y con ello ofrecer a la sociedad una serie de expertos que estén capacitados para analizar, debatir y proponer soluciones a los problemas filosóficos que se derivan de la actividad científica. Bunge nos habla de revitalizar la carrera de filosofía, la cual parece que prepara más especialistas en filosofía antigua y medieval, que filósofos propiamente dichos. También denuncia la falta de cultura científica de los especialistas en filosofía y la ignorancia filosófica de los científicos profesionales. Si esta situación sigue así, comentaba Bunge en el 57 aunque el problema aún continúa hasta hoy, estamos condenados a seguir viendo esa separación abismal entre ciencia y filosofía, con especialistas de ambas áreas despreciándose unos a otros.

Una de las áreas que une la rigurosidad y el respeto por los hechos que muestra toda ciencia, y el análisis lógico de conceptos y la formalización de la filosofía exacta, es la epistemología. Pero, ¿qué es la epistemología? El concepto puede causar cierta confusión ya que más de un libro lo utiliza como sinónimo de gnoseología o teoría del conocimiento. Pero esta confusión es innecesaria y puede evitarse si se define de forma clara el área de la epistemología.

Puede decirse entonces, por un lado, que la gnoseología es la rama de la filosofía que se ocupa del estudio de los principios del conocimiento. El conjunto de cuestiones, debates y respuestas sobre ¿qué es el conocimiento?, ¿qué podemos llegar a conocer?, ¿cómo conocemos? entre otras cuestiones, forman parte de la gnoseología. Esta área se ha visto enriquecida sobre todo gracias a las ciencias cognitivas que nos ofrecen respuestas a muchas de estas preguntas, generando nuevas cuestiones. Desde luego, el que la ciencia cognitiva nos ayude a resolver problemas gnoseológicos no significa que la gnoseología se quede sin campo de estudio; las ciencias cognitivas también presentan un fondo gnoseológico en el cual apoyan sus nuevas hipótesis. No podemos saber si algún día la gnoseología acabará siendo una ciencia cognitiva más, adquiriendo independencia de la filosofía; lo que sí sabemos, es que la gnoseología representa la cuna de una serie de problemas fascinantes sobre nuestra relación (como sujetos) con el universo (como objeto de estudio).

Pero la epistemología no se ocupa de problematizar sobre los problemas del conocimiento, así, de forma general. Tal vez podríamos ver a la epistemología como "gnoseología especializada", pues se enfoca en problematizar sobre un tipo de conocimiento muy especial: el conocimiento científico. La epistemología es el mejor ejemplo de un enlace de filosofía y ciencia.

La epistemología busca debatir y proponer respuestas a preguntas como ¿qué es el conocimiento científico?, ¿cuáles son los principios filosóficos presupuestos en la investigación científica?, ¿qué es el método científico?, ¿existe "el" método científico como un proceso lineal e inmutable?, ¿cuáles son las diferencias entre ciencia, semiciencia, protociencia y pseudociencia?, ¿son lo mismo ciencia y tecnología?, ¿la ciencia presupone la realidad autónoma y la legalidad del mundo?, ¿cómo se relacionan las teorías científicas con la realidad y la experiencia?, ¿la ciencia puede ir más allá de los fenómenos y la relación entre éstos?, ¿es posible describir las cosas reales con minuciosidad y una precisión perfecta?, ¿qué son las leyes y las explicaciones científicas?, ¿qué función desempeñan las matemáticas en las ciencias factuales?, ¿la filosofía puede desempeñar una función constructiva en la investigación científica?, ¿la ciencia está moralmente comprometida?, ¿existen límites al avance de la ciencia? Cuestionarse sobre los principios, fines y la naturaleza de la ciencia es el primer paso para hacer epistemología.

Mario Bunge enfatiza en esto al decirnos que la epistemología es pues, la filosofía de, en, desde, con y para la ciencia. Filosofía de la ciencia hace referencia al examen filosófico de la ciencia (sus problemas, sus métodos, su estructura, etc.). Filosofía en la ciencia (o más exactamente filosofía de la ciencia en la ciencia) comprende el estudio de las implicaciones filosóficas de la ciencia, el examen de las categorías e hipótesis que intervienen en la investigación científica, o que emergen en la síntesis de sus resultados. Es pues, el estudio de las hipótesis filosóficas que en ciencia se presuponen y se utilizan como punto de partida. La filosofía desde la ciencia sugiere que se trata de una filosofía que hace hincapié en la ciencia, que ha sustituido la especulación sin freno por la investigación guiada en el método científico, teniendo un respeto profundo por los hechos empíricos y por la consistencia lógica. Filosofía con la ciencia trata de una filosofía que acompaña a la ciencia, es decir, una filosofía que está al margen de los logros de la ciencia, que no se pone a especular sinsentidos sobre el ser y el tiempo. Por último, la filosofía para la ciencia sugiere una filosofía que no solo se nutre de la ciencia, sino que aspira a serle útil, que busca servir para establecer, por ejemplo, las diferencias que existen entre la definición y el dato, o entre la verdad factual y la proposición que es verdadera o falsa, independientemente de los hechos. Esta es una filosofía que no sólo escarba en los fundamentos filosóficos que las ciencias admiten, sino que además busca aclarar la estructura y función de los sistemas científicos, señalando relaciones y posibilidades inexploradas.

Pero hablar de filosofía de, en, desde, con y para la ciencia tal vez sea demasiado largo y poco estético. ¿Por qué no mejor utilizar un sólo concepto: epistemología?, o ¿por qué no llamarlo sólo filosofía de la ciencia? Una disciplina que resulta ser, por su objeto de estudio, una metaciencia. Pues bien, un epistemólogo como tal no puede ser un filósofo que pregona una filosofía contra, sobre y/o bajo la ciencia. Una filosofía contra la ciencia (tal como han existido y siguen existiendo) resultará ser una filosofía irracionalista, que desprecia el respeto por los hechos y la consistencia. Una filosofía contra la ciencia resulta ser anticientífica. Este tipo de posturas son las que alimentan doctrinas como las del fundamentalismo religioso, la tecnofobia y el activismo contra la investigación y aplicación científica. Quien filosofa contra la ciencia, o aun al margen de ella, ignorándola por completo (tal como nos dice Bunge) imita a los escolásticos que rehusaban mirar por el anteojo astronómico de Galileo.

Si hablamos de una filosofía sobre la ciencia estamos haciendo referencia a una disciplina superior rectora de las disciplinas científicas. Aunque éste ha sido el anhelo de muchos que en el pasado se han llamado a sí mismos "epistemólogos", lo cierto es que estos intentos no han sido otra cosa más que la burla de los científicos, pues siempre han mostrado grados intolerables de arrogancia combinados con ignorancia científica. Si quieres hacer que la comunidad científica se burle de la filosofía y la desprecie, tan sólo di que la filosofía es superior a la ciencia y que la primera le dice cómo actuar a la segunda.

Por otro lado, la expresión filosofía bajo la ciencia sugiera una posición inversa, como si la filosofía dependiera de forma absoluta de la ciencia. Este error, aunque poco común entre los filósofos que miran sus propuestas casi siempre como superiores a los anteriores, suele ser expresado como una virtud epistemológica. Sin embargo, la filosofía de la ciencia no sólo comporta el examen de los supuestos filosóficos de la investigación científica, sino que tiene derecho a una elaboración creadora de un nivel diferente del científico aunque reposa sobre éste último: el nivel metacientífico.

La comprensión precisa de la epistemología como la principal disciplina filosófica que, estando al margen de la ciencia, la cuestiona, la crítica y la analiza como la manifestación humana que es, probablemente sea el primer paso para comprender la relación tan estrecha entre filosofía y ciencia. Algo importante a comprender es que no todo el que tiene título en filosofía es un epistemólogo, del mismo modo que el no tener título en filosofía no significa que no se sea (o no se pueda ser) epistemólogo. Existen filósofos con perspectiva científica y científicos con inquietudes filosóficas que enriquecen por igual esta disciplina fascinante. Un segundo paso para este mismo propósito sería hablar de los logros e importancia de la epistemología para con la investigación, la aplicación y la divulgación de la ciencia, pero eso ya será tema para otra entrada.

*Publicación original en La pipa de Russell.

Acerca del Autor:

Daniel Galarza Santiago es estudiante de filosofía en el Centro Universitario de Ciencias Sociales y Humanidades (CUCSH) de la Universidad de Guadalajara. Autor de los blogs El escéptico de Jalisco y La pipa de Russell, también ha colaborado en otros espacios en línea tales como Blog Escéptico, Despertando Mentes, Magufobusters, Escépticos Unidos Mexicanos y Fundación Richard Dawkins para la Razón y la Ciencia.

Los cazadores del último bosón. A dos años del descubrimiento del bosón de Higgs.

Hace más de dos años, el 4 de julio de 2012, científicos de la Organización Europea para la Investigación Nuclear (CERN por sus siglas en inglés) mataron dos pájaros de un tiro: hicieron que Stephen Hawking perdiera una apuesta de cien dólares y pusieron fin a la búsqueda más intensiva de la que la ciencia moderna tiene registro. Esta búsqueda requirió de la construcción del Gran Colisionador de Hadrones (LHC), el complejo científico más grande del mundo con un costo superior a los nueve mil millones de dólares y un equipo de trabajo de más de diez mil científicos e ingenieros de todo el mundo. ¿Qué era lo que buscaban estos físicos con tanto empecinamiento? ¿Qué descubrimiento monumental requería de esfuerzos tan notables por parte de la comunidad científica internacional? Nada monumental, por el contrario, la búsqueda era en pos de algo en un orden de magnitud tan pequeño, que resulta incluso incomprensible. Lo que encontraron fue la última pieza de un rompecabezas llamado Modelo Estándar de las Partículas Elementales, una partícula que daría coherencia a los modelos físicos actuales. La infame, pero popularmente llamada Partícula de Dios: el bosón de Higgs.

Un gran descubrimiento… que no sorprendió a muchos

La primera imagen que viene a mi cabeza cuando recuerdo esa primera semana de julio de 2012 es la de un montón de periodistas tratando de explicar al mundo la importancia de un evento científico que sabían era de gran relevancia, pero que en realidad, no comprendían en lo más mínimo. Y es que la física de partículas subatómicas rara vez llega a los titulares, pero este descubrimiento ameritaba todos los reflectores.

Después de más de dos décadas de planeación, construcción y calibración de la instalación experimental más grande y compleja jamás construida, el Gran Colisionador de Hadrones cumplió el objetivo para el que había sido diseñado: la detección de una partícula cuyas características correspondían a las predicciones de lo que se esperaba era el bosón de Higgs.

El descubrimiento del bosón corrobora las predicciones teóricas que Peter Higgs, Gerald Guralnik, Richard Hagen, Tom Kibble, Robert Brout y Françoise Englert realizaron en la década de los sesentas –¡la cacería duró cerca de medio siglo!- con respecto a la física de partículas subatómicas. El hallazgo, que le brindó el premio Nobel a Higgs y a Englert, era el último eslabón para que el Modelo Estándar estuviera completo, validando el trabajo de décadas de muchos físicos teóricos. La comunidad científica esperaba con ansias la comprobación de la existencia del bosón, ¡no podía no existir! La alternativa, un escenario mucho más interesante para la ciencia según Stephen Hawking, hubiera implicado el replanteamiento de muchos de los postulados físicos vigentes. La existencia comprobada del bosón de Higgs abre la puerta a nuevas concepciones sobre la forma en la que se comporta nuestro universo y podría ser el parte aguas para superar el Modelo Estándar y dar paso a una “nueva física”.

Se estarán preguntando ¿por qué tanto alboroto?, ¿qué es lo que hace a esta partícula tan especial? o ¿por qué la física moderna dependía de su descubrimiento? Para responder todo esto tenemos que empezar por una pregunta más general… ¿qué demonios es un bosón?

La naturaleza cuántica de un bosón

A mediados del siglo pasado, los físicos elaboraron el Modelo Estándar, una ambiciosa colección de ecuaciones y postulados cuyo objetivo es describir el comportamiento de todas las partículas subatómicas y la forma en las que estas interactúan. Es una teoría de casi todo y, aunque no considera elementos como la fuerza de gravedad o la materia obscura, es el modelo más ambicioso de la física moderna.

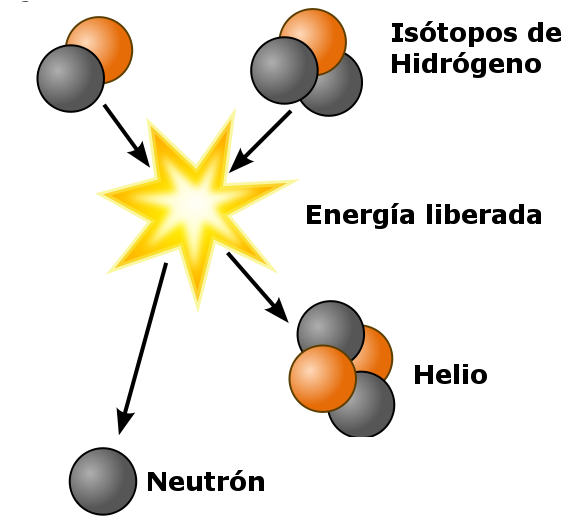

De acuerdo al Modelo Estándar, todas las partículas pueden ser divididas en dos grupos: los fermiones y los bosones. Los fermiones son las partículas subatómicas que constituyen la materia y se dividen a su vez en quarks (que conforman a los protones y neutrones) y leptones (de los cuales el electrón es el más conocido). Los bosones, por otro lado, son las partículas responsables de las fuerzas fundamentales asociadas a la naturaleza. Los fotones, por ejemplo, son los bosones relacionados con el electromagnetismo; los gluones, se encuentran asociados a las interacciones fuertes de los núcleos atómicos, responsables de que protones y neutrones no se desintegren en un frenesí de quarks; y los bosones W y Z se relacionan a las interacciones débiles, responsables de cambiar las propiedades de los quarks y de otras curiosidades como el decaimiento radiactivo y la fusión nuclear que mantiene al Sol brillando y generando calor para que podamos aprovechar un buen día de playa. Hasta aquí todo “fácil”.

¿Qué papel juega Higgs en todo esto?

En el Modelo Estándar bosones y fermiones interactúan alegremente para darle forma al universo como lo conocemos, permitiendo la expansión de las galaxias, la formación de estrellas y la vida en nuestro planeta. Para que esta armonía sea posible, las interacciones entre materia y energía deben ajustarse a ciertas reglas o simetrías. Sin embargo, la evidencia empírica empezó a jugar en contra del modelo: había partículas con más masa de la esperada, fuerzas que actuaban de forma distinta a lo predicho… ¡El caos! ¡Sería necesario reevaluar todos los postulados de la física moderna! ¡Tardaríamos décadas en reconstruir un modelo igual de robusto! O…podríamos intentar balancear el Modelo Estándar tomando en cuenta las anomalías y ver qué pasa.

El postulado teórico que vino a balancear el Modelo Estándar es asombroso. En teoría, el universo estaría embebido en una especie de red –el Campo de Higgs- encargada de suministrar de masa a la materia del universo. ¡Todas las partículas del universo obtienen su masa por la interacción con este campo y el bosón de Higgs es una expresión de esta interacción! ¿Confundidos? Intentemos visualizar lo siguiente. Imagínense que el universo se reduce a la superficie de un –enorme- charco de lodo. Sobre la superficie del charco hay un sinnúmero de canicas, algunas se deslizan sobre la superficie tan rápido que no dejan rastro de su paso y ni siquiera se embarran de lodo, otras cruzan por el charco con menos gracia y no se libran de alguna salpicadura y están aquellas que van rodando sin mayor preocupación y están hechas una porquería. Las primeras canicas corresponden a las partículas que carecen de masa, como los fotones. Las segundas corresponden a fermiones como los electrones y a algunos bosones que tienen masas muy bajas. Las últimas canicas son los quarks, componentes de los protones y neutrones del núcleo de los átomos. En esta pequeña analogía, el campo de Higgs sería el lodo y el bosón de Higgs… ¡las ondas que se forman por la interacción entre las canicas y el lodo!

Explicar el campo y el bosón de Higgs resulta tan complicado que a finales del siglo pasado, el Ministerio de Ciencias del Reino Unido ofreció una botella de champaña de la mejor calidad a aquel que realizara la analogía más sencilla al respecto. El premio se lo llevo David Miller del University College of London. Aquí les dejo una interpretación animada de su solución, esperando que, entre ésta y el lodazal, queden claros los conceptos más generales del campo de Higgs.

http://www.youtube.com/watch?v=joTKd5j3mzk

A dos años de detectar el bosón

La historia del bosón de Higgs, desde su concepción hasta su descubrimiento, es uno de los mejores ejemplos de cómo debe funcionar la ciencia moderna. Por un lado, nos demostró el poder que tienen las teorías científicas para realizar descripciones y predicciones sobre nuestro universo. Pero también es un recordatorio de que la única forma de validar nuestras ideas, debe ser a través del método científico.

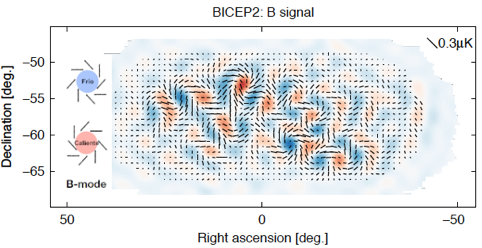

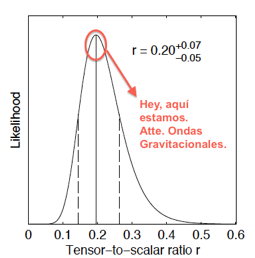

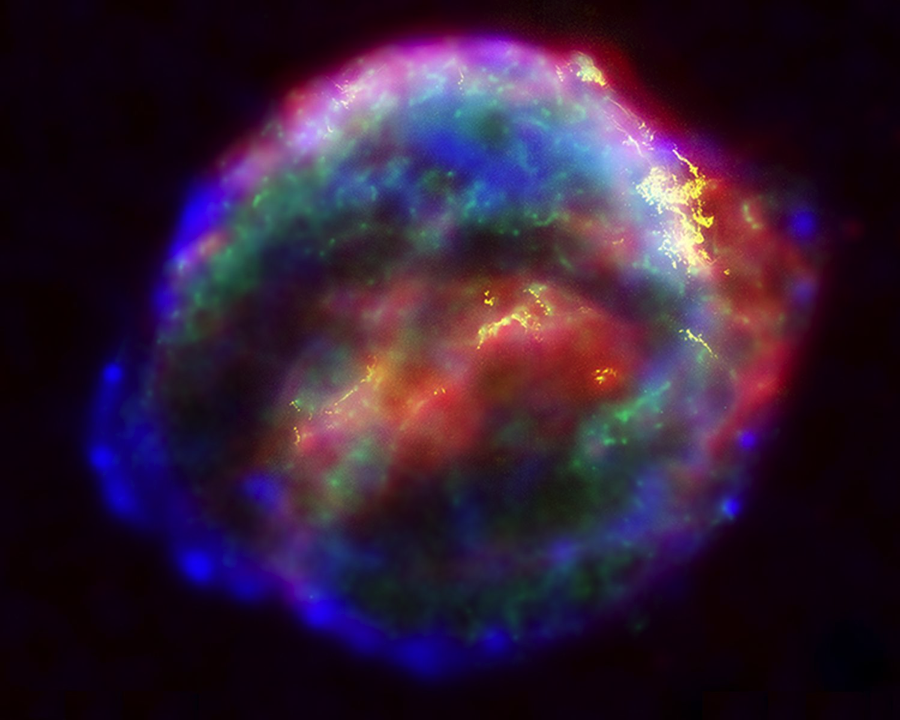

El túnel principal del Gran Colisionador de Hadrones no ha visto muchas colisiones recientemente y, contrario a lo esperado por actores sensacionalistas de opiniones pseudocientíficas, todavía no ha destruido al universo. El mantenimiento es costoso y llevará tiempo. Sin embargo, los datos que se generaron en el complejo durante su periodo operativo siguen siendo analizados y los resultados siguen sorprendiendo a muchos. Hoy se cuenta con evidencia (observen la primera imagen de este artículo) de el decaimiento del bosón de Higgs hacia fermiones (su descubrimiento se basó exclusivamente en el decaimiento a bosones de baja masa) y se tienen más elementos para analizar a fondo la naturaleza del campo de Higgs. Recientemente se presentó el plan de trabajo para los próximos años de los distintos experimentos activos en el LHC.

El Modelo Estándar está completo. Ahora, la labor de la ciencia es terminar de entenderlo y expandirlo con la ayuda de las nuevas evidencias. Seguimos muy lejos de tener una “teoría de todo”, pero no cabe duda que dimos un paso gigante en esa dirección.

El gato de Schrödinger: ¿estaba entonces vivo o muerto?

¿Puede un gato estar vivo y muerto a la vez? En esta colaboración, nuestro amigo Juan de Pedazos de Carbono responde esta pregunta y nos explica por qué. ------

Seguramente habrás escuchado, quizá sin enterarte mucho de los detalles, sobre la paradoja del famoso gato de Schrödinger. Yo mismo sabía desde hace años sobre este experimento mental, pero fue hace poco gracias a la explicación de Jim Al-Khalili en “Paradox” que finalmente entendí la solución a esta aparente paradoja. La respuesta sobre si todo este tiempo el gato estaba vivo o muerto es: sí. Pero mejor déjenme explicar antes la pregunta.

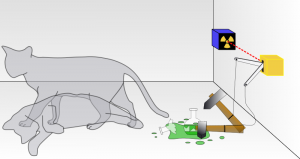

El gato de Schrödinger, ¿simultaneamente vivo y muerto? / Imagen: Dhatfield *

Erwin Schrödinger se preguntó lo que pasaría si colocamos a un gato dentro una caja especialmente preparada y después la cerramos. Dentro de la caja se encuentra también una muy pequeña cantidad de algún material radioactivo, tan pequeña que en el transcurso de una hora hay sólo un 50% de probabilidad de que el material emita una partícula cargada de energía. Si la partícula es emitida entonces activará un detector que, a su vez, liberará un potente ácido matando al gato de forma instantánea. (Recuerda: es un experimento mental, ¡ningún gato ha sido lastimado pensando en las implicaciones de este experimento!)

Si repitiéramos el experimento muchas veces—colocamos un gato en la caja, cerramos la caja, esperamos una hora, abrimos la caja—la mitad de las veces encontraríamos un gato muerto (cuando se emitió la partícula) y la mitad de las veces un gato vivo (cuando la partícula no fue emitida). Esto puede sonar un poco cruel, pero nada extraño. Schrödinger notaba que lo realmente absurdo es que, según la física cuántica, cuando la caja estaba cerrada la partícula fue “emitida” y “no emitida” al mismo tiempo. En el mundo cuántico ambas posibilidades ocurrieron simultáneamente en realidad y, por consecuencia, mientras no mirábamos el gato estaba simultáneamente vivo y muerto. Más aún, parecería que nuestra acción de abrir la caja y observar el interior fue lo que “decidió” el destino del gato.

¡Eso sí que suena completamente absurdo! ¿Qué tenemos de especial que con sólo observar podemos estar decidiendo el destino de los gatos?

Antes de contestar estas preguntas, y revelar la solución a la aparente paradoja, quizá sea importante entender exactamente qué es lo que dice la física cuántica, y por qué es que sabemos que lo que dice es cierto.

Un electrón, por poner un ejemplo, en realidad no es una pequeña canica que se encuentre siempre en algún lugar determinado. La posición del electrón se puede entender más bien como una onda, cuya amplitud está relacionada con la probabilidad de encontrar al electrón en distintos sitios. Ojo, no se trata de que seamos nosotros los que no sepamos la posición exacta del electrón y por lo tanto usemos probabilidades como una aproximación, el hecho es que el electrón realmente se encuentra en distintos sitios al mismo tiempo.

Esto puede comenzar a sonar algo bizarro pero la verdad es que, hasta este punto, la situación no es muy distinta a lo que ocurre cuando dejas caer una piedra en un lago y observas las ondas producidas sobre la superficie. La onda no está localizada en un punto exacto sobre el lago, sino distribuida y ocupando distintos sitios al mismo tiempo. De modo similar, al chocar unos con otros los electrones “interfieren” entre ellos—sumándose o cancelándose sus amplitudes—del mismo modo como lo hacen las ondas en el lago.

El comportamiento de los electrones no es muy distinto al de las ondas en la superficie de un lago / Foto: Scott Robinson

Esto se puede comprobar en el famoso experimento de la doble rejilla donde a un solo electrón se le hace pasar por dos caminos distintos que—al juntarse después de nuevo—ocasionan que el electrón haga interferencia “consigo mismo”. Espero que con la explicación que acabo de dar te puedas hacer en la mente una idea más o menos de lo que está sucediendo. No es muy complicado. Quizá nunca lo habías pensado de esta manera, pero también te darás cuenta que no es tan descabellado como sonaba en un principio.

Lo realmente inesperado y sorprendente es lo siguiente: si en uno de los dos caminos pones un detector para determinar si el electrón pasó o no pasó por ahí, entonces los patrones de interferencia desaparecen y el electrón parece ser forzado a elegir entre tomar “uno” o “el otro” camino, ya no ambos al mismo tiempo. Pareciera que el electrón puede felizmente recorrer los dos caminos distintos al mismo tiempo mientras nadie lo mira, pero al observarlo el electrón es forzado a elegir una y sólo una de las dos opciones.

El párrafo anterior contiene una de las ideas centrales de la física cuántica, la que daba dolores de cabeza a Schrödinger, y de la que surgen muchas de las otras extrañezas que seguro has escuchado sobre física cuántica. Y no se trata de filosofía ni de un experimento mental, esta es en realidad la forma en que los electrones—al igual que fotones y otras partículas energéticas—se comportan cuando se les estudia en el laboratorio. Este es un hecho de nuestro universo.

Desafortunadamente ésta es también la idea de la física cuántica que más suele ser mal interpretada, dando dar lugar a ideologías como “El Secreto” o toda la pseudo-filosofía de Deepak Chopra. Y es que el experimento parece decir que las cosas no son “reales” hasta que las observamos, que nuestro acto consciente de observar al mundo es el que ocasiona que el destino se desenlace de una u otra manera. “Tu mente decide la realidad.” Pero esto no es así.

Lo curioso es que la solución a este malentendido resuelve también la paradoja del gato de Schrödinger. Y es que el “observar” que hace que un electrón tome uno u o otro camino—o que una partícula se emita o no se emita, y por lo tanto se produzca o no la muerte del gato—no requiere una mente consciente que esté “observando”. No requiere un humano, ni siquiera un par de ojos: el electrón es “observado” al interactuar de cierta manera con cualquier otro sistema—por ejemplo un detector de electrones—en un proceso llamado decoherencia cuántica.

El gato no pudo estar vivo y muerto al mismo tiempo pues, si en algún momento el detector “observa” que la partícula radioactiva es emitida, a partir de entonces el destino de la partícula—y fatalmente también del gato—ha sido definido. La respuesta es entonces que sí, en todo momento el gato está vivo o muerto—según el detector determine—pero nunca se encontraba en ambos estados al mismo tiempo.

En conclusión los efectos cuánticos son reales, pero solo aplican en escalas muy pequeñas del tamaño de los átomos, así como a electrones, fotones y partículas más pequeñas. En cuanto tienes un sistema más grande y complejo—como un detector, un gato, o una persona a quien le gustan los gatos—el proceso de decoherencia pronto ocurre y los efectos cuánticos desaparecen. Cuando se entiende un poco más la física cuántica no parece ya taaan extraña, ¿verdad?

Juan

--

Escrito por Juan A. Navarro Pérez y publicado originalmente en Pedazos de Carbono

* La imagen aquí utilizada para ilustrar el gato de Schrödinger es distinta a la que se presentó en la versión original de Pedazos de Carbono

Gimnasia artrópoda en Río 2016.

Estamos de regreso para la transmisión en vivo de los Juegos Olímpicos de Verano Río 2016. ¡Vaya competencia pudimos presenciar entre los equipos femeninos de handball! Tal parece ser que la Noruega da la ventaja, justo como hace cuatro años. Ahora inicia la gimnasia artíst... ¿artrópoda? Ah, es verdad. La gimnasia artrópoda. Uno de los nuevos juegos olímpicos que se inauguran aquí, en Río 2016. En la arena se encuentra Ángela Pereira, nuestra enviada especial. Ángela, ¿nos escuchas?

Ángela: ... ¡Hola, Carlos! Un saludo al auditorio que nos sintoniza. Así es: me encuentro aquí en la arena donde se realizará en unos minutos la inauguración de un nuevo deporte olímpico, la gimnasia artrópoda. El comité olímpico ha decidido integrarlo a la lista a pesar de la notable escasez de competidoras.

Estamos de regreso para la transmisión en vivo de los Juegos Olímpicos de Verano Río 2016. ¡Vaya competencia pudimos presenciar entre los equipos femeninos de handball! Tal parece ser que la Noruega da la ventaja, justo como hace cuatro años. Ahora inicia la gimnasia artíst... ¿artrópoda? Ah, es verdad. La gimnasia artrópoda. Uno de los nuevos juegos olímpicos que se inauguran aquí, en Río 2016. En la arena se encuentra Ángela Pereira, nuestra enviada especial. Ángela, ¿nos escuchas?

Ángela: ... ¡Hola, Carlos! Un saludo al auditorio que nos sintoniza. Así es: me encuentro aquí en la arena donde se realizará en unos minutos la inauguración de un nuevo deporte olímpico, la gimnasia artrópoda. El comité olímpico ha decidido integrarlo a la lista a pesar de la notable escasez de competidoras.

Carlos: Según tengo entendido, sólo se han presentado representantes de cuatro países: Estados Unidos, Inglaterra, Sudáfrica y Marruecos. ¿No es así, Ángela?

Ángela: ... ¡Así es, Carlos! Sin embargo, el comité olímpico ha hecho esta decisión debido a la habilidad sin precedentes de estas competidoras. Y parece que estamos a punto de comenzar. Puedo ver a las gimnastas estirarse en el otro extremo de la arena, concentradas. La dinámica será la siguiente: cada una de ellas tendrá que demostrar sus habilidades con una coreografía libre. Terminada su rutina, los jueces las calificarán de acuerdo a su fuerza, flexibilidad, agilidad y elegancia.

Carlos: Suena fascinante. ¿Nos puedes presentar a las competidoras?

Ángela: ... ¡Claro que sí, Carlos! La primera de ellas, Cicindela dorsalis, se acerca decidida a la arena. Originaria de Carolina del Sur, Estados Unidos, esta gimnasta –la más joven de todas, pues es apenas una larva– pertenece a una especie de escarabajos tigre. Oh, parece que ya está lista. Cicindela sube a la barra de equilibrio y estira todo su cuerpo antes de iniciar. De un salto, comienza su coreografía y se contorsiona por completo en el aire. Cae perfectamente en línea sobre la barra de equilibrio y... ¡comienza a girar! A girar, te digo. ¡Como una rueda, Carlos! Vuelve a dar un salto y cae victoriosa sobre la arena. Wow, nunca había visto algo así.

Carlos: ¿Como una rueda? Bastante impresionante, Ángela. Dime, ¿hay alguna forma de que podamos ver en acción a esta deportista? Ángela: ... ¡Por supuesto, Carlos! Pueden ver la coreografía grabada de Cicindela desde este enlace: Pero esperen. Ya llega la siguiente competidora al salto de potro: Pleurotya ruralis o, como la llaman en su casa, la polilla Madre de Perla. Esta gimnasta inglesa es también una larva, pero algo me dice que tiene mucha más experiencia que la pequeña Cicindela. Ahora arrastra cada uno de sus pies y flexiona la cabeza, preparándose. Pleurotya sale disparada hacia el potro, anclando el extremo posterior de su cuerpo, doblándose y rodando. ¡Whoa! ¡Tremendo salto de esta gimnasta y qué buen aterrizaje! Parece que... Oh, sí. Ahora Pleurotya rueda hacia atrás, salta y termina su coreografía en el mismo punto donde comenzó. ¡Qué belleza, Carlos! Miren qué belleza

Carlos: Supongo que la gimnasia artrópoda ha superado las expectativas de más de uno. Quién lo hubiera dicho.

Ángela: ... ¡Quién lo hubiera dicho, Carlos! Las tribunas todavía no se recuperan de toda esta emoción. Yo misma estoy agitada. El mundo entero debería de estar viendo esto. Y qué momento más oportuno: a la arena entra la araña sudafricana Carparachne aureoflava, nativa del desierto de Namib. Debo decirles que esta es una de las gimnastas más experimentadas. ¡Y qué manera de demostrarlo! Ni bien ha comenzado la música, Carparachne ya domina el suelo, haciendo magia con sus patas mientras gira sobre sí misma. Carlos, debes ver esto. Carparachne ahora comienza a dar vueltas de carro a una velocidad impresionante alrededor de la arena. Según me informan, da 44 vueltas por segundo. ¡Qué cosa! Termina su rutina con una carismática vuelta y, como puedes escuchar, el lugar se inunda de aplausos.

Carlos: ¿44 vueltas por segundo, has dicho? Vaya, creo que yo no puedo dar una sola. Jaja, ¿y tú, Ángela?

Ángela: ... ¡No hay tiempo de responder, Carlos! Y es que ya ha empezado la coreografía de la última concursante: la araña marroquí Cebrennus rechenbergi. Debo decirte que nadie sabía muy bien qué esperar de ella porque apenas fue descubierta en marzo de 2014, pero ahora nos da un espectáculo memorable. ¡Qué agilidad, qué elegancia! Gira, corre y se detiene por un segundo mientras se pavonea frente a nuestros ojos. Una verdadera artista. ¡Sus vueltas de carro son algo espectacular, Carlos! Quizá no sea la más veloz, pero eso no impide que deje a los jueces con la boca abierta. ¡Miren nada más!

Carlos: Una enorme sorpresa por parte de las gimnastas arácnidas. Pero no puedo evitar preguntarte, Ángela, ¿cómo es que estos animales son tan brillantes en un deporte olímpico como la gimnasia?

Ángela: (sollozando) ... ¡Disculpa, Carlos! Estas sólo son lágrimas de emoción. Qué buena pregunta. Ni yo misma lo sé. Supongo ... sus habilidades ... servirán ... escape ante amenazas como depredadores, ¿no?

Carlos: Vaya, Ángela. Hasta pareces científica. Eh, parece que pasa algo con la transmisión. ¿Me escuchas bien?

Ángela: ...

Carlos: ... Parece que ha ocurrido una falla técnica con nuestra enviada a los Juegos Olímpicos Río 2016. Nos vamos a un corte, pero al regresar veremos la entrevista exclusiva que nos dio el multi-medallista estadunidense Michael Phelps. Además, ¿cómo se alimentan los deportistas olímpicos para mantenerse en forma aquí, en Río 2016? ¡No se vayan!

Bibliografía:

Nota en Scientific American | Nota II en Scientific American | Artículo del Descubrimiento de Cebrennus rechenbergi | Nota original en el Blog de Historias Cienciacionales.

No todo es lo que parece. Agallas, manzanas de roble e insectos.

Vas de excursión, caminando en medio del bosque. Ya pasaron unas horas desde que te comiste tu último sándwich y desapareciste la última manzana. Ves una fruta redonda, rojiza y que parece estar cubierta de pelos. Está en medio de las rosas silvestres, lo cual te parece curioso. De cualquier modo, de inmediato piensas que ha de ser algo similar al rambután. Esa fruta dulce parecida a los lichis. No parece haber nada más a la redonda y, dado que llevas un rato sin comer, suena a una buena botana. Tomas tu navaja y la partes a la mitad antes de pelarla. Entonces ves algo que de inmediato te quita el hambre. Sucede que la fruta que tomaste no es tal y un gusanito blanco te observa pasmado desde su interior.

Ilustración 1. Agalla causada por una avispa Diplolepis. Fotografiada por J.R. Crellin.

Las agallas (fitomas, cedidios o abogallas) son estructuras inducidas en las plantas por la presencia de un organismo extraño como puede ser un insecto, bacteria o virus. Algunas se ven tan sólo como pequeñas protuberancias en las hojas.

Ilustración 2. Diplolepis rosae en Rosa canina. Tomada el 25 de agosto de 2007 por Frank Vincentz.

En inglés se les denomina gallnuts (nueces de bilis) o insect-galls (bilis de insecto) debido al sabor amargo característico de los taninos que contienen, los cuales son sustancias amargas producidas por las plantas que precipitan proteínas. La existencia de estos taninos permitió que antiguamente las agallas se emplearan para curtir pieles. En la edad media se utilizaron como fármacos y se les atribuían propiedades adivinatorias. Se creía que el año dependería de si dentro de la agalla se encontraba un gusano, una mosca o una araña. Si había un gusano habría hambre, si era una mosca guerra y si era una araña pestilencia. También fueron utilizadas para la elaboración de colorantes y tinta. En el este de África las mujeres somalíes utilizaban un tipo de agalla para realizar tatuajes. ¡Incluso llegaron a usarse para alimentar al ganado!

Es común que los árboles de aguacate se infecten de Trioza, un insecto cuyas ninfas (un estado anterior al adulto) viven en agallas en las hojas de aguacate. Por su aspecto, es claro que estas agallas son un elemento extraño en la planta; sin embargo, hay algunas que tienen un aspecto tan similar al de las frutas o brotes de hojas que son casi indistinguibles de las estructuras normales de las plantas. Tal es el caso de las “manzanas de roble”, que son agallas dentro de las cuales crecen las larvas de una especie de avispa llamada Amphibolips confluenta. En México, éstas suelen verse también en los encinos y llegan a alcanzar ocho centímetros de diámetro. Aunque no tienen precisamente la misma forma de las manzanas, su color rojizo o amarillento hace que se confundan fácilmente con frutos.

Ilustración 3. Manzana de Roble producida por Trichoteras vaccinifoliae. Fotografiada por Ron Russo para Confessions of a Gall Hunter en la Revista de Historia Natural (Natural History Magazine).

De acuerdo con Margaret M. Fagan, las agallas causadas por Discholcaspis weldi (una especie de avispa) en Quercus reticulata (un roble) podían adquirirse en puestos de frutas de la Ciudad de México.

Las agallas a las que nos referimos en el inicio de este texto han sido llamadas Diplolepis bicolor y son causadas en las rosas por otro tipo de avispas. Estas son comunes en Canadá y Estados Unidos, donde frecuentemente son fotografiadas por excursionistas.

Debido a sus propiedades, a lo inesperado que resulta hallar un insecto viviendo dentro de una “frutilla” y a la variedad de formas que pueden generar (más allá de los vistosos cuasi-frutos), las agallas han despertado el interés de la comunidad científica desde hace muchos años. Inicialmente interesaba medir cómo afectan las agallas el crecimiento y rendimiento de las plantas. En algunos trabajos sobre fósiles de agallas, se les han calculado edades de más de 300 millones de años, lo cual nos habla de lo antigua que es esta relación entre las plantas y los insectos.

A pesar del tiempo que llevan estudiándose, los mecanismos moleculares por los cuales los insectos logran controlar el desarrollo de las plantas para formar estas intrincadas estructuras, aún son un misterio. Se saben, y en algunos casos se sospechan, cuáles podrían ser algunas de las moléculas involucradas en estos procesos, pero aún hay mucho por averiguar. En principio, llama la atención que unos cuantos cambios, como mordeduras de los insectos y las sustancias que el insecto le transmite a la planta por medio de su saliva, puedan generar este tipo de respuesta. Ante la presencia de estrés, algunas células de las plantas cambian de un tipo celular a otro para reparar y neutralizar los cambios. Pero si el estímulo es muy fuerte, la planta suele matar a las células bajo la influencia del insecto u otro parásito para asegurar la supervivencia del resto del organismo.

Sabemos que hay pasos clave para que los insectos consigan formar una agalla completa, como el reconocimiento de la llegada del insecto por parte de la planta, la señalización que se da dentro de la planta después de reconocer esta llegada, el crecimiento de la agalla y la diferenciación observable. De momento, como se mencionó anteriormente, una pieza clave parece ser la saliva. Científicos que estudian este tema proponen que la saliva genera un “choque” químico que altera el estado de las células generando el estrés que lleva a la célula a cambiar de tipo celular en un intento por compensar los daños. Incluso los mismos compuestos dentro de la célula, al ser expulsados cuando la planta es mordida por un insecto, podrían ser los que estén induciendo el estrés que es clave en el inicio de la formación de una agalla.

Las agallas reciben una gran cantidad de señales bioquímicas provenientes de las hojas sobre las que crecen. Por lo general, dichas señales ayudan a que una hoja se desarrolle normalmente, pero las agallas logran diferenciarse independientemente de estas señales, desarrollando estructuras impresionantes.

Las plantas no son los únicos organismos que pueden verse afectados por avispas, ya que estos insectos también pueden inducir comportamientos extraños en arañas, cucarachas y otros organismos que parasitan. Algunos investigadores han comparado este comportamiento con un estado “zombie”, que lleva al ser infectado a suicidarse o dejarse llevar ciegamente por su captor. Llama mucho la atención ya que otras presas, como las mariposas, sólo son paralizadas y no exhiben estos cambios de comportamiento. En las cucarachas, las avispas logran imponer su control por medio de un “cóctel” neurotóxico que suprime la actividad de algunas neuronas, cambiando así la “motivación” de la cucaracha por caminar. Con esta acción la avispa impide que la cucaracha escape del nido donde la avispa la coloca. Este es otro ejemplo de una respuesta extraña y compleja lograda con una señal sencilla.

Además de ser procesos por sí mismos muy interesantes, el estudio de la formación de estos brotes falsos conocidos como agallas y el control que ejercen las avispas sobre el sistema nervioso de otros organismos, ayuda a entender cómo se dan otros procesos como la diferenciación y simetría en las plantas.

[hozbreak]

Bibliografía y literatura adicional

Agallas sobre Quercíneas es un documento en español del 2006 de la Universidad de Aragón, revisado por los Doctores Pedro del Estal, José Luís Nieves-Aldrey y Juli Pujade-Villar. Este documento contiene una breve introducción acerca de las agallas, en donde se comenta, a grandes rasgos, cómo actúan algunos insectos inductores de agallas.

On predatory wasps and zombie cockroaches: Investigations of “free will” and spontaneous behavior in insects, es una revisión donde Ram Gal y Frederic Libersat discuten cómo se da el control mental de las avispas hacia las cucarachas.

Fossil oak galls preserve ancient multitrophic interactions de Graham N. Stone y sus colaboradores es un artículo del 2008 en donde los autores describen un fósil de agallas. Lo interesante del artículo es que, a pesar de haber evidencia fósil previa, este espécimen está muy bien conservado y es muy detallado.

En The Effects of Stem Gall Insects on Life History Patterns in Solidago canadensis de David C. Hartnett y Warren G. Abrahamson (1979), los autores hicieron una exploración acerca de los posibles efectos de las agallas en las poblaciones de plantas.

The Uses of Insect Galls de Margaret M. Fagan (1918) es, a pesar de ser un artículo antiguo, una revisión muy interesante de los usos que los seres humanos le habíamos dado hasta ese entonces a las agallas de insectos y de cómo hemos ido comprendiendo su naturaleza.

Morphogenesis of insect-induced plant galls: facts and questions, de Anantanarayanan Raman (2011) es una revisión que nos habla de las evidencias actuales de cómo funcionan las agallas de insectos y de qué falta por saber.

[hozbreak]

Acerca del autor

Libertad Pantoja Hernández nació en la Ciudad de México. Estudió Ciencias Genómicas en el campus Morelos de la UNAM. En el 2008 y 2009 participó el concurso iGEM de máquinas genéticas. Actualmente estudia el Doctorado en Ciencias Biomédicas en la UNAM y participa en el Taller de Narrativa impartido por Alberto Chimal. Cada vez que puede escribe y dibuja.

Una nueva receta cósmica

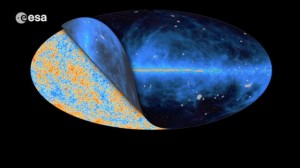

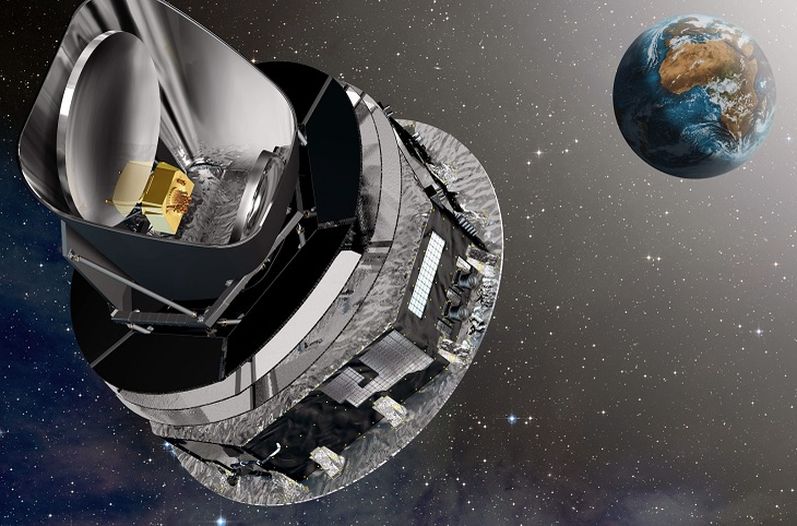

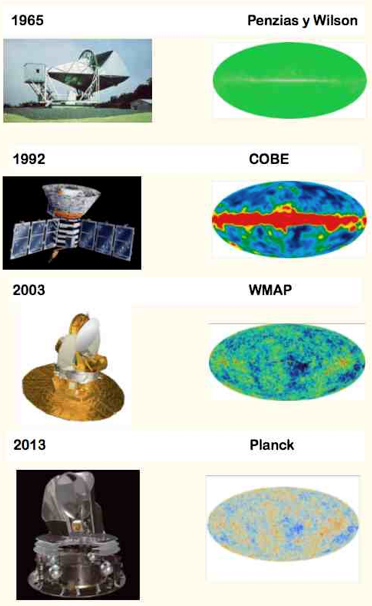

Continuando con las ideas del post “Por qué Planck aún no termina de sorprender…”, hagamos un breve resumen de la nueva apariencia de nuestro Universo que la Misión Planck nos proporcionó hace ya más de un año:

- El Universo tiene una edad de 13.82 mil millones de años.

- El Universo se está expandiendo un poco más lentamente que lo que se esperaba.

- El Universo contiene 4.9 % de materia ordinaria, 26.8 % de materia oscura y 68.3 % de energía oscura.

- El Universo es asimétrico: sólo un poco, sólo un indicio, pero que tiene profundas implicaciones.

¿Qué significa todo esto? Demos un vistazo a estos resultados.

Tan viejito como lleno de misterio.

La edad del Universo es mayor de lo que esperábamos. Hace algunos unos años, la sonda de Anisotropía de Microondas Wilkinson (WMAP, por sus siglas en inglés) miró el Universo tanto como el satélite Planck lo ha hecho recientemente, y por el momento tiene la mejor determinación de la edad cósmica: 13.73 ± 0.12 mil millones de años.

La misión Planck descubrió que el Universo es casi 100 millones de años más antiguo: 13.82 mil millones de años, lo cual es consistente con la estimación reportada por la sonda WMAP, pero las mediciones del satélite Planck se consideran más refinadas. Esta nueva cantidad se convertirá en el nuevo punto de referencia para los astrónomos.

El Universo se expande un poco más lento de lo que esperábamos.