En el fondo de los mares de Tazmania esperaba una sorpresa que ha de sacudir el árbol de la vida animal desde su tronco, si lo que proponen sus descubridores resulta verdad. Hace más de 27 años, el zoólogo Jean Just, del Museo de Historia Natural de la Universidad de Copenhague en Dinamarca, recogía los ejemplares de animales recolectados entre 400 y 1,000 metros de profundidad sin sospechar que entre las redes tenía ejemplares de un tipo de animal que no se podría ubicar en ninguna clasificación conocida. Se trataba de organismos milimétricos en forma de hongo que, sin embargo, mostraban las características básicas de los animales: son multicelulares y sus células tienen núcleo (así que no son bacterias ni protozoarios) y tienen estructuras para digerir la comida que ingieren (así que no son algas ni plantas). Esto, no obstante, Just no lo sabría hasta años después, cuando se puso a analizar a detalle todo lo que tenía pendiente de aquel crucero del ‘86. Y fue hasta esta semana que publicó, junto con algunos colegas suyos de su universidad, el resultado de sus análisis: estos animales, a los que bautizó con el nombre de género Dendrogramma, no se pueden ubicar en ningún grupo conocido y los organismos con los que guardan más similitud son fósiles que existieron hace unos 600 millones de años.

Uno de los científicos que primero leyeron su artículo, según relatan los autores en el mismo texto, sugirió que estos animales debían fundar un nuevo filo en la clasificación. Los filos, (o phyla, como prefieren decirles los científicos), son las ramas más gruesas de la taxonomía tradicional sólo después de los reinos. Además, por las características de estos minúsculos organismos, probablemente sean uno de los filos más antiguos del reino.

En el fondo de los mares de Tazmania esperaba una sorpresa que ha de sacudir el árbol de la vida animal desde su tronco, si lo que proponen sus descubridores resulta verdad. Hace más de 27 años, el zoólogo Jean Just, del Museo de Historia Natural de la Universidad de Copenhague en Dinamarca, recogía los ejemplares de animales recolectados entre 400 y 1,000 metros de profundidad sin sospechar que entre las redes tenía ejemplares de un tipo de animal que no se podría ubicar en ninguna clasificación conocida. Se trataba de organismos milimétricos en forma de hongo que, sin embargo, mostraban las características básicas de los animales: son multicelulares y sus células tienen núcleo (así que no son bacterias ni protozoarios) y tienen estructuras para digerir la comida que ingieren (así que no son algas ni plantas). Esto, no obstante, Just no lo sabría hasta años después, cuando se puso a analizar a detalle todo lo que tenía pendiente de aquel crucero del ‘86. Y fue hasta esta semana que publicó, junto con algunos colegas suyos de su universidad, el resultado de sus análisis: estos animales, a los que bautizó con el nombre de género Dendrogramma, no se pueden ubicar en ningún grupo conocido y los organismos con los que guardan más similitud son fósiles que existieron hace unos 600 millones de años.

Uno de los científicos que primero leyeron su artículo, según relatan los autores en el mismo texto, sugirió que estos animales debían fundar un nuevo filo en la clasificación. Los filos, (o phyla, como prefieren decirles los científicos), son las ramas más gruesas de la taxonomía tradicional sólo después de los reinos. Además, por las características de estos minúsculos organismos, probablemente sean uno de los filos más antiguos del reino.

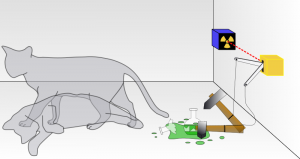

Una forma de hacer una división gruesa de todos los animales es por su simetría. Se traza una línea imaginaria en el cuerpo del animal y se busca si los lados son un reflejo uno del otro. Si es así, se tiene a un animal de simetría bilateral. Esto ocurre con casi todos los animales en los que uno pueda pensar: humanos, cangrejos, escorpiones, tiburones blancos, moscas de la fruta, lombrices, nematodos, pulpos... Si no ocurre así, probablemente se trate de una medusa o una esponja. A las medusas se les puede partir en “rebanadas”, así que tienen simetría radial (si se les mira desde arriba) y las esponjas no tienen simetría en absoluto. Esta forma de dividir a los animales no sólo es geométricamente divertida, sino que también informa sobre la antigüedad de los grupos. Se cree que los animales sin simetría en sus cuerpos surgieron antes que los de simetría radial, y éstos surgieron antes que los de simetría bilateral. Los animales que Just examinó durante varios años en la mesa de su laboratorio, y que sólo mostró al mundo después de estar seguro de lo que veía, tienen a duras penas una simetría radial, y esto le hace pensar que pueden ser más antiguos que las medusas. ¿Serán tan antiguos como los primeros animales?

“Sería increíblemente emocionante si los autores hubieran encontrado un grupo desconocido de animales que divergió de los otros animales hace tanto tiempo”, dice un biólogo evolutivo entrevistado para el sitio de noticias de la revista Nature. Los 600 millones de años de antigüedad que tienen los fósiles con los que Just y sus colegas le encuentran parecido a Dendrogramma trazarían su rama del árbol de la vida hasta el momento en el que surgían los primeros esbozos de lo que significa ser animal.

Aquellos fósiles pertenecen a un grupo de animales llamados “fauna de Ediacara”, nombrados así por el estrato geológico en el que se les encontró. En ellos no hay rastro de patas, aletas, conchas, apéndices, órganos, sistemas o casi todo lo que vemos en los animales actuales. De hecho, muchos de ellos probablemente tenían una vida parecida a la que hubiera tenido una hierba submarina. Se piensa que, salvo contados casos, esos primeros intentos de animales no dejaron descendencia hacia eones posteriores, porque sus extrañas formas no tienen ningún eco en los animales que les siguieron. Hasta que Just y sus colegas encontraron a Dendrogramma.

Una forma adicional de encontrar similitud entre estos animales y todos los demás que existen en el mundo sería a través de su ADN. Desafortunadamente, por las técnicas de preservación que los zoólogos usaron durante su colecta, les es imposible recuperar esas moléculas de los tejidos. Hasta que se vuelvan a encontrar más ejemplares vivos de Dendrogramma, se podrán hacer los estudios necesarios para averiguar si estos animales, con su extraña forma fungoide y su actitud de “soy de lo más básico que un animal podría ser”, realmente provienen de las raíces del árbol de la vida que se hunden en las nieblas del tiempo evolutivo.

Fuentes:

Artículo Original en laRevista PLOS | Nota en la Revista Nature | Nota original en el Blog de Historias Cienciacionales