En la entrega anterior del blog se explicó qué es el Sistema Centinela y el método de muestreo utilizado para tomar una muestra representativa de la población con el objetivo de determinar la incidencia de enfermedades infecciosas. En esta segunda parte discutimos cómo el estudio de una fracción de casos ayuda a estimar el total de individuos con COVID-19 en una población.

COVID-19, analizando al Centinela y otros modelos: Primera Parte

El 2020 parece no darnos tregua y sin duda la mayor crisis mundial de los últimos meses es la pandemia de COVID-19. La misteriosa enfermedad que apareció entre los pobladores de Wuhan, China a finales 2019 y se ha expandido por el mundo. Hasta el momento en el que se está redactando este texto, se han confirmado arriba de 3 millones y medio de casos y 100 mil muertes a nivel mundial. En México se han reportado hasta hoy más de 25 mil casos confirmados y 2 mil muertes a nivel nacional; sin embargo, hace unas semanas el Dr. Hugo López-Gatell informó que se estiman más de 100 mil casos de COVID-19 a nivel nacional utilizando el Sistema de Vigilancia Centinela. Entonces ¿Qué es el sistema Centinela? ¿Cómo funciona? ¿Es el sistema adecuado para modelar esta epidemia?

Del campo al motor, el bioetanol en México: Segunda parte

En la primera parte de este artículo, escribimos sobre la importancia de promover un desarrollo sostenible tanto a nivel social como industrial. En esta sostenibilidad, el papel de la bioeconomía es importante pues establece los criterios para la gestión de los recursos naturales. Describimos la importancia de la biorrefinación como alternativa al uso de combustibles fósiles y el papel de México en esta iniciativa.

Del campo al motor, el bioetanol en México: Primera parte

Tratamiento con más frío que calor

El acero es una aleación de hierro y carbono; la cantidad del segundo varía entre 0,03% y 1,075% en peso de su composición, dependiendo del grado. Puede utilizarse para aplicaciones como trabajos en frío, utilizados en procesos de corte u operaciones que dan forma a un producto que no será expuesto a altas temperaturas.

La paradoja de Simpson

Imaginemos que queremos comparar dos métodos didácticos para averiguar cuál es mejor. Para evitar preocuparnos por un periodo de adaptación a los métodos, simplemente tomamos dos escuelas que ya usan cada uno de ellos, y enseñamos a los alumnos un nuevo tema. Al final, hacemos un examen, y vemos cuántos alumnos pasan.

El secreto del acero

Leyendo Rayuela

Una de las obras maestras de la literatura latinoamericana, Rayuela de Julio Cortázar, tiene una característica muy peculiar: sus 155 capítulos pueden ser leídos en varios órdenes distintos. Cortázar mismo sugiere un par de esos órdenes, pero al menos en teoría la novela puede ser leída en cualquier orden que el lector prefiera.

Si lo mexicano es naco, y lo mexicano es chido...

Algunos lectores se acordarán de una famosa canción de Botellita de Jerez donde cantan “Si lo mexicano es naco, y lo mexicano es chido, entonces [...] todo lo naco es chido.” Para quienes no la conozcan, o quieran recordar viejas épocas, la canción la pueden escuchar aquí; la frase en cuestión aparece en el minuto 2:50 (advertencia: partes de la letra no son muy políticamente correctas).

Enfermedades en peligro de extinción

Se puede pensar que los objetivos principales de la medicina son tratar y curar enfermedades. Pues bien, prevenirlas es otra de sus metas y, en muchos casos, una aún más importante que el manejo y la cura. Las enfermedades se pueden prevenir de muchas maneras que dependen del patógeno causal, del mecanismo de contagio y diseminación, del periodo latente e infeccioso de una enfermedad, etc. Sin embargo, una de las herramientas más efectivas para la prevención colectiva de enfermedades infecciosas es la vacunación.

¿Cómo funcionan las encuestas?

En estos días está de moda hablar de encuestas. Cuando tenemos elecciones, los adultos con derecho al voto marcamos nuestra preferencia con respecto a los candidatos. Pero antes de que eso ocurra, muchos de nosotros queremos darnos una idea sobre el posible resultado. Ahí es donde aparecen las encuestas.

Bacterias que comen plástico

¿Te has puesto alguna vez a pensar en la cantidad de plástico que usas en tu vida diaria? Más específicamente, ¿la cantidad de plástico que desechas cada día? ¿Cuántas botellas de agua o de refresco por semana? ¿Cuántos vasitos, bolsas, contenedores o envolturas desechables? Pues bien, la mayor parte de estos objetos están hechos de Tereftalato de polietileno, mejor conocido como PET, el tipo de plástico más producido del mundo.

La Bionanotecnología y sus conceptos

El vertiginoso desarrollo de la ciencia ha logrado avances impresionantes que necesitan ser divulgados entre la sociedad. Entre las nuevas fascinaciones de las mujeres y hombres de ciencia se encuentra la Bionanotecnología o también llamada Ingeniería Biomolecular, que destaca tanto por sus aportaciones a la ciencia e incidencia en el desarrollo tecnológico como por su carácter altamente interdisciplinario y polifacético donde convergen diferentes enfoques provenientes de la biología, química, física e ingeniería.

¿Qué es la bionanotecnología?

La bionanotecnología se origina de la fusión entre la nanotecnología y la biotecnología. Por un lado, la nanotecnología es la construcción y modelaje de la materia manipulando átomo por átomo aplicada en la ingeniería y manufactura a escala nanométrica. Por el otro, la biotecnología aprovecha diversas funcionalidades derivadas de procesos biológicos para aplicaciones específicas sin que importen los detalles moleculares y atómicos de las biomoléculas que llevan a cabo dichos procesos. Con base en ello, la bionanotecnología se define como la ingeniería y manufactura aplicada al diseño y modificación de los detalles atómicos de maquinarias y dispositivos moleculares basados en biomoléculas (ácido desoxirribonucleico -ADN-, proteínas, lípidos y carbohidratos) para que lleven a cabo funciones especificas a nivel nanométrico construidos mediante ensambladores biomoleculares. El rápido avance científico hace que el ámbito de influencia de la bionanotecnología aun se esté definiendo.

Para tener idea de las dimensiones de dichas máquinas es necesario decir que un nanómetro es la milmillonésima parte de un metro, o bien en nuestro mundo macroscópico equivaldría a comparar una moneda con el ¡diámetro de la tierra! La capacidad de visualización y manipulación de diminutos átomos y moléculas se logra con instrumentos y técnicas sofisticadas y refinadas de microscopía, cristalografía, espectroscopia y modelaje en computadora.

Las biomoléculas son las protagonistas

Las biomoléculas son los componentes de la célula desarrollados y optimizados a través de millones de años de evolución natural que mantienen la vida celular llevando a cabo todas las funciones necesarias para su crecimiento, sobrevivencia y reproducción.

A pesar de que la célula es un sistema altamente complejo, base de la vida, se puede hacer una analogía (muy pobre, pero muy efectiva) con una máquina o un sistema compuesto de varias máquinas. Por ejemplo, el flagelo bacteriano y el complejo ATP sintasa funcionan esencialmente como motores generando movimiento mecánico alrededor de un eje y bombeando protones, mientras que la miosina realiza la contracción muscular; los anticuerpos y receptores de membrana detectan diversas moléculas por lo que son sensores; la actina y los microtúbulos son vigas y soportes, las enzimas son herramientas reparadoras y constructoras, los ribosomas son los ensambladores que construyen nuevas máquinas proteínicas en líneas de producción, el ADN es el control numérico, los lípidos forman vesículas contenedoras y la membrana lipídica que rodea la célula tal como si fuera una carcasa, etcétera. Todas estas entidades biológicas son delicadas moléculas de tamaño nanométrico con propiedades basadas principalmente en la química y debido a que en esencia realizan funciones de máquinas con precisión atómica también pueden ser caracterizadas y optimizadas con enfoques de la física y la ingeniería.

La célula crea las biomoléculas

Debido a que las biomoléculas son productos exclusivos del metabolismo celular, el desarrollo de la biología molecular en las últimas décadas ha sido de gran ayuda para la bionanotecnología permitiendo conocer los detalles de los mecanismos de muchas de estas “nanomáquinas”.

De inmensa importancia ha sido el desarrollo de la tecnología del ADN recombinante en la expansión de la bionanotecnología ya que ha permitido modificar y producir en gran escala de forma barata y rápida las “bionanomáquinas” y biomateriales necesarios para la bionanotecnología. Como el ADN posee toda la información necesaria para generar una proteína funcional (la gran mayoría de las “bionanomáquinas” están compuestas de proteína), es decir, contiene secuencias de ácidos nucleicos que codifican para los aminoácidos de una proteína, solo basta alterar y editar las secuencias del ADN para modificar una proteína particular con precisión atómica y así optimizar su funcionamiento y propiedades o generar nuevas y novedosas máquinas de proteína, las cuales son producidas en gran cantidad a partir de substratos baratos al crecer la célula con el gen en particular. La capacidad de manipular la célula es sin duda un cambio de paradigma que ha revolucionado tanto la ciencia como la forma en que vemos al mundo.

La Bionanotecnología trabaja interdisciplinariamente

Además de optimizar y modificar las biomoléculas a escala nanométrica para aplicaciones específicas, la bionanotecnología se ha adentrado en nuevos caminos y consolidado como un área altamente interdisciplinaria. Fusionándose con la ciencia de materiales ha desarrollado novedosos materiales híbridos entre compuestos inorgánicos y bioorgánicos, superando así la tradicional separación entre estos dos tipos de materia y borrando las fronteras entre la materia viva e inanimada.

Esta área usa proteínas y ácidos nucleicos como unidades programables de reconocimiento molecular, las cuales son acopladas (ligadas químicamente) a nanopartículas inorgánicas con propiedades ópticas, electrónicas y catalíticas diversas e interesantes, útiles para elaborar materiales y dispositivos inteligentes basados en compuestos híbridos que se auto-ensamblan en complejos supramoleculares nanométricos usados en aplicaciones bioanalíticas y biomédicas para diagnóstico, visualización y tratamiento de enfermedades y también para computación, electrónica, óptica y manufactura molecular.

Borrando Fronteras entre la Materia

El punto cardinal en la Bionanotecnología es la materia y la disolución de la frontera bioorgánica/inorgánica. Objetos vivos e inanimados están hechos por átomos. Las propiedades de la materia cambian de acuerdo con el patrón en que estén ordenados y enlazados los diferentes átomos que la componen: carbón y diamante, arena y chips de computadora, cáncer y tejido sano, tienen cierta disposición que hace la diferencia entre lo enfermo de lo sano y lo barato de lo valioso, tal como dice el apóstol de la nanotecnología, Erik Drexler en su famoso libro Máquinas de creación.

Hemos entrado en la era conjunta de la manipulación atómica y genética. Hay muchos riesgos pero también mucho potencial, que bien balanceado y en un ambiente democrático puede ser aprovechado para atender problemáticas específicas dentro del contexto mexicano.

Así, los bionanotecnólogos han creado nuevos horizontes en la ciencia, han descubierto excitantes áreas de desarrollo tecnológico y científico, novedosas e inéditas aplicaciones de las biomoléculas y han generado hitos de interdisciplinariedad al asociar disciplinas comúnmente separadas. La pregunta es, parafraseando al Nobel Richard Feynman en su discurso inaugural de la nanotecnología, ¿habrá suficiente espacio en el fondo de nuestra mente para apoyar la bionanotecnología en México?

Escrito por Armando Hernández y publicado originalmente en su blog acerca de bionanotecnología

[hozbreak]

Acerca del autor

Argumentos, datos y posturas sobre cómo conservar la biodiversidad del Nevado de Toluca

Colaboración de Alicia Mastretta Yanes, Renata Cao, Sergio Nicasio Arzeta, Paulo Quadri, Tania Escalante Espinosa, Libertad Arredondo y Daniel Piñero

En esta entrada resumimos cuáles han sido las diferentes posturas desde el punto de vista de la biología y del manejo de recursos naturales en uno de los sucesos más importantes que la política de la conservación mexicana ha visto: por decreto presidencial, el 1ro de octubre del 2013, el Nevado de Toluca dejó de ser un Parque Nacional y pasó a ser un Área de Protección de Flora y Fauna. Planteamos también por qué un correcto diagnóstico ambiental es indispensable y cómo, como científicos y sociedad, debemos proponer mejores opciones de manejo a las autoridades.

Quienes promovieron el cambio de categoría y realizaron el estudio previo justificativo se sustentan en el siguiente argumento: por definición, los parques nacionales deben ser propiedad de la nación, sin embargo, el Nevado de Toluca y muchos otros parques nacionales del país pertenecen a ejidos y propietarios privados; estas condiciones incapacitan a los dueños de la tierra para un sustento económico de manera legal, por lo que recurren a la tala ilegal y a actividades agropecuarias que no se encuentran permitidas. Lo anterior, argumentan, ha llevado al deterioro ambiental del Nevado de Toluca a grado tal que la conservación de su biodiversidad se encuentra en grave riesgo.

Esta es una postura compartida entre el Dr. Gerardo Ceballos del Instituto de Ecología de la UNAM, el PROESNEVADO (un programa especial del gobierno del Estado de México) y un grupo de forestales de la Universidad Autónoma del Estado de México. Puede consultarse más en extenso en un artículo de divulgación científica que el Dr. Ceballos escribió para la revista Oikos del Instituto de Ecología de la UNAM.

Por otro lado, preocupados porque el cambio de categoría lograra conservar la biodiversidad del Nevado de Toluca y los servicios ambientales que nos brinda, un grupo de biólogos y geólogos de diversas instituciones nacionales (UNAM, INECOL, entre otros) y extranjeras (University of East Anglia, University of California Santa Cruz e IPNA-CSIC), entre los que nos encontramos la Biól. Alicia Mastretta Yanes, el Dr. Daniel Piñero, la Mtra. Libertad Arredondo, el Mtro. Paulo Quadri, la Dra. Tania Escalante y 30 científicos más, decidimos revisar el programa de manejo de la ahora Área de Protección de Flora y Fauna Nevado de Toluca.

El programa de manejo es el documento que dicta y regula las actividades y su ubicación dentro del territorio del Área Natural Protegida y con qué acciones la Comisión Nacional de Áreas Naturales Protegidas (CONANP) garantizará la conservación de su biodiversidad. Tras revisar los artículos científicos citados por el programa de manejo y por el estudio previo justificativo, y después de realizar nuevos análisis, concluimos que el proceso de recategorización y el borrador del programa de manejo tienen vacíos de información y datos o interpretaciones incorrectas, tanto desde el punto vista ambiental, como socioeconómico y de política pública.

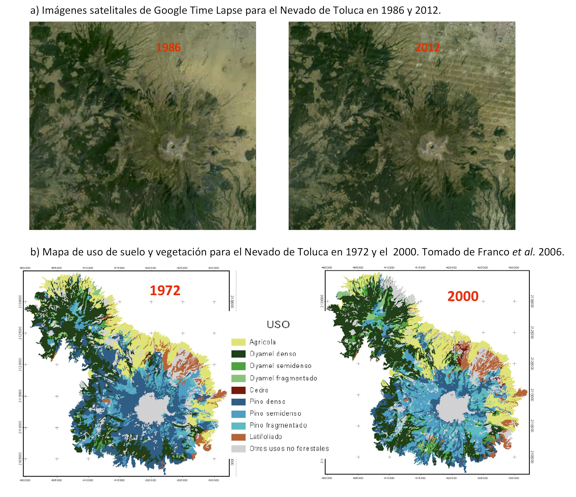

Por ejemplo, el deterioro del área natural protegida no es homogéneo ni responde a las mismas causas que hace 40 años (Figura 1). Además, la tasa de deforestación planteada en el programa de manejo está sobrestimada y en realidad se refiere a la pérdida de densidad arbórea (detalle en este link). Todo lo cual oculta el hecho de que no todos los tipos de bosque se encuentran afectados. En el mismo número de la revista Oikos, hemos publicado un artículo de divulgación donde resumimos el resultado de estos y otros análisis.

El área abierta a la agricultura (amarillo) en el Nevado de Toluca no aumentó de 1972 al 2012 y los bosques de oyamel (verde oscuro) y latifoliadas (marrón) no disminuyeron en densidad ni en cobertura. Las imágenes satelitales de 1986 y del 2012 están disponibles en Google Timelapse y el artículo de Franco et al. 2006 aquí (parte A) y aquí (parte B).

Hemos insistido mucho en los problemas técnicos con los datos del estudio previo justificativo y del programa de manejo porque es con ellos que se realizó el diagnóstico ambiental y con los que se está fundamentando cómo manejar al Nevado de Toluca. En otras palabras, al igual que con una enfermedad humana, si el diagnóstico es incorrecto el tratamiento también lo será y perjudicará en vez de beneficiar. La labor del médico que lo descubra es informarlo y empezar cuanto antes con el tratamiento que sí sea adecuado.

En el caso del Nevado de Toluca, lo preocupante es que no existe evidencia de que las actividades y zonificación propuestas por el borrador del programa de manejo del 2013 (y de su nueva versión al 2014), crearán las condiciones socio-ambientales necesarias para conservar al Nevado de Toluca y para mejorar la calidad de vida de sus habitantes. El manejo que tendría el Área Natural Protegida no está diseñado para favorecer la conservación de su biodiversidad y la restauración de los bosques que se encuentran degradados, sino que favorece que los bosques que sí están conservados sean abiertos a la explotación forestal.

Lo que los proponentes del cambio de categoría están haciendo es promover una visión de explotación de los recursos naturales en lugar de una de conservación y manejo con bases ecológicas y de visión sistémica. Este cambio de paradigma pone en gravísimo riesgo la conservación de la biodiversidad, los servicios ambientales que nos brinda el Nevado de Toluca y no garantiza beneficios sociales para los pobladores locales.

Nuestro involucramiento con la CONANP empezó en noviembre del 2013 en respuesta a la consulta pública sobre el borrador del programa de manejo del 2013. En los subsecuentes nueve meses realizamos una serie de propuestas para mejorarlo, principalmente en torno a la Subzonificación. El 1ro de agosto del 2014, la CONANP puso a consulta pública la segunda versión del borrador del programa de manejo. Dicha versión modificó nuestras propuestas sin brindarnos argumentos técnicos sólidos que lo justificaran.

Actualmente, la consulta pública de la segunda versión está abierta a revisión, es por eso que invitamos a los interesados a consultarla y realizar recomendaciones.

La obligación de las autoridades es atender las observaciones de la ciudadanía y la comunidad científica, pues cualquier argumento para modificar los instrumentos regulatorios de un área natural protegida debe realizarse con datos fidedignos y poder sostenerse ante una evaluación estricta y crítica. De forma subsecuente, la CONANP debe garantizar que el manejo de un área natural protegida afectada por dichos cambios se hará en pro de la conservación y del bien común.

[hozbreak]

La foto del Nevado de Toluca al inicio de esta entrada fue tomada por Benjamin Bernal.

[hozbreak]

Acerca de los autores

A. Mastretta Yanes es bióloga egresada de la UNAM. Del 2007 al 2010 trabajó en proyectos de manejo sustentable de recursos naturales y pago por servicios ambientales. Actualmente realiza su doctorado en la University of East Anglia, Inglaterra. Su proyecto estudia el efecto de los cambios climáticos históricos en la distribución de la diversidad genética en plantas de las montañas más altas del centro de México.

R. Cao es bióloga egresada de la UNAM. Del 2011 al 2013 trabajó en proyectos de conservación y manejo sustentable de los recursos naturales en la Selva Lacandona. Este año egresó de la Maestría en Gestión Ambiental, Conservación y Manejo Sustentable de Recursos Naturales por la Universidad de Queensland, Australia, en donde enfocó sus estudios al manejo y gestión de Áreas Naturales Protegidas.

S. Nicasio Arzeta es biólogo egresado de la UNAM. Desde 2011 es estudiante de doctorado en el Centro de Investigaciones en Ecosistemas en Morelia. Su proyecto consiste en evaluar el potencial del territorio con actividades humanas para mantener la conectividad del paisaje de mamíferos terrestres y plántulas de árboles dentro de fragmentos de bosque tropical húmedo en la Selva Lacandona.

P. Quadri estudió comunicación en la Universidad de las Américas Puebla. Del 2007 al 2010 trabajó en la CONANP. Es maestro en estudios ambientales por la Universidad de Yale en los Estados Unidos. Actualmente es estudiante de doctorado en el departamento de Estudios Ambientales de la Universidad de California, donde investiga las relaciones entre cambios en la cobertura y uso del suelo, microclimas y el funcionamiento de las comunidades y ecosistemas en bosques del centro de México.

T. Escalante Espinosa realizó sus estudios de doctorado y posdoctorado en la UNAM. Actualmente es profesora Titular A de tiempo completo en la Facultad de Ciencias de la UNAM en el grupo de trabajo de Biogeografía de la Conservación, del Departamento de Biología Evolutiva. Sus líneas de investigación son la biogeografía, la biología de la conservación, la distribución de la biodiversidad y la mastozoología.

L. Arredondo-Amezcua es Maestra en Ciencias por el Centro de Investigaciones en Ecosistemas de la UNAM. Actualmente trabaja como técnico externo para el proyecto de la Flora alpina del centro de México, para el Instituto de Ecología A.C. – Centro Regional del Bajío; cuyo objetivo es inventariar la diversidad florística de los pastizales alpinos de los volcanes más altos de la Faja Volcánica Transmexicana, así como su estado de conservación.

D. Piñero es investigador del Instituto de Ecología de la UNAM. Dirige proyectos sobre genética de poblaciones de plantas, en particular de filogeografía y estructura genética en especies mexicanas.

Epistemología: filosofía de/en/desde/con/para la ciencia

En su célebre conferencia de 1957 (convertida después en el último capítulo del libro La ciencia, su método y su filosofía) titulada "Filosofar científicamente y encarar la ciencia filosóficamente", el epistemólogo Mario Bunge le cuenta a sus alumnos (tanto de aquel tiempo como los que ahora lo leemos) la necesidad urgente de generar epistemólogos de primer nivel en Latinoamérica, con el fin de incrementar la difusión y el estudio de los fundamentos de la ciencia, y con ello ofrecer a la sociedad una serie de expertos que estén capacitados para analizar, debatir y proponer soluciones a los problemas filosóficos que se derivan de la actividad científica. Bunge nos habla de revitalizar la carrera de filosofía, la cual parece que prepara más especialistas en filosofía antigua y medieval, que filósofos propiamente dichos. También denuncia la falta de cultura científica de los especialistas en filosofía y la ignorancia filosófica de los científicos profesionales. Si esta situación sigue así, comentaba Bunge en el 57 aunque el problema aún continúa hasta hoy, estamos condenados a seguir viendo esa separación abismal entre ciencia y filosofía, con especialistas de ambas áreas despreciándose unos a otros.

Una de las áreas que une la rigurosidad y el respeto por los hechos que muestra toda ciencia, y el análisis lógico de conceptos y la formalización de la filosofía exacta, es la epistemología. Pero, ¿qué es la epistemología? El concepto puede causar cierta confusión ya que más de un libro lo utiliza como sinónimo de gnoseología o teoría del conocimiento. Pero esta confusión es innecesaria y puede evitarse si se define de forma clara el área de la epistemología.

Puede decirse entonces, por un lado, que la gnoseología es la rama de la filosofía que se ocupa del estudio de los principios del conocimiento. El conjunto de cuestiones, debates y respuestas sobre ¿qué es el conocimiento?, ¿qué podemos llegar a conocer?, ¿cómo conocemos? entre otras cuestiones, forman parte de la gnoseología. Esta área se ha visto enriquecida sobre todo gracias a las ciencias cognitivas que nos ofrecen respuestas a muchas de estas preguntas, generando nuevas cuestiones. Desde luego, el que la ciencia cognitiva nos ayude a resolver problemas gnoseológicos no significa que la gnoseología se quede sin campo de estudio; las ciencias cognitivas también presentan un fondo gnoseológico en el cual apoyan sus nuevas hipótesis. No podemos saber si algún día la gnoseología acabará siendo una ciencia cognitiva más, adquiriendo independencia de la filosofía; lo que sí sabemos, es que la gnoseología representa la cuna de una serie de problemas fascinantes sobre nuestra relación (como sujetos) con el universo (como objeto de estudio).

Pero la epistemología no se ocupa de problematizar sobre los problemas del conocimiento, así, de forma general. Tal vez podríamos ver a la epistemología como "gnoseología especializada", pues se enfoca en problematizar sobre un tipo de conocimiento muy especial: el conocimiento científico. La epistemología es el mejor ejemplo de un enlace de filosofía y ciencia.

La epistemología busca debatir y proponer respuestas a preguntas como ¿qué es el conocimiento científico?, ¿cuáles son los principios filosóficos presupuestos en la investigación científica?, ¿qué es el método científico?, ¿existe "el" método científico como un proceso lineal e inmutable?, ¿cuáles son las diferencias entre ciencia, semiciencia, protociencia y pseudociencia?, ¿son lo mismo ciencia y tecnología?, ¿la ciencia presupone la realidad autónoma y la legalidad del mundo?, ¿cómo se relacionan las teorías científicas con la realidad y la experiencia?, ¿la ciencia puede ir más allá de los fenómenos y la relación entre éstos?, ¿es posible describir las cosas reales con minuciosidad y una precisión perfecta?, ¿qué son las leyes y las explicaciones científicas?, ¿qué función desempeñan las matemáticas en las ciencias factuales?, ¿la filosofía puede desempeñar una función constructiva en la investigación científica?, ¿la ciencia está moralmente comprometida?, ¿existen límites al avance de la ciencia? Cuestionarse sobre los principios, fines y la naturaleza de la ciencia es el primer paso para hacer epistemología.

Mario Bunge enfatiza en esto al decirnos que la epistemología es pues, la filosofía de, en, desde, con y para la ciencia. Filosofía de la ciencia hace referencia al examen filosófico de la ciencia (sus problemas, sus métodos, su estructura, etc.). Filosofía en la ciencia (o más exactamente filosofía de la ciencia en la ciencia) comprende el estudio de las implicaciones filosóficas de la ciencia, el examen de las categorías e hipótesis que intervienen en la investigación científica, o que emergen en la síntesis de sus resultados. Es pues, el estudio de las hipótesis filosóficas que en ciencia se presuponen y se utilizan como punto de partida. La filosofía desde la ciencia sugiere que se trata de una filosofía que hace hincapié en la ciencia, que ha sustituido la especulación sin freno por la investigación guiada en el método científico, teniendo un respeto profundo por los hechos empíricos y por la consistencia lógica. Filosofía con la ciencia trata de una filosofía que acompaña a la ciencia, es decir, una filosofía que está al margen de los logros de la ciencia, que no se pone a especular sinsentidos sobre el ser y el tiempo. Por último, la filosofía para la ciencia sugiere una filosofía que no solo se nutre de la ciencia, sino que aspira a serle útil, que busca servir para establecer, por ejemplo, las diferencias que existen entre la definición y el dato, o entre la verdad factual y la proposición que es verdadera o falsa, independientemente de los hechos. Esta es una filosofía que no sólo escarba en los fundamentos filosóficos que las ciencias admiten, sino que además busca aclarar la estructura y función de los sistemas científicos, señalando relaciones y posibilidades inexploradas.

Pero hablar de filosofía de, en, desde, con y para la ciencia tal vez sea demasiado largo y poco estético. ¿Por qué no mejor utilizar un sólo concepto: epistemología?, o ¿por qué no llamarlo sólo filosofía de la ciencia? Una disciplina que resulta ser, por su objeto de estudio, una metaciencia. Pues bien, un epistemólogo como tal no puede ser un filósofo que pregona una filosofía contra, sobre y/o bajo la ciencia. Una filosofía contra la ciencia (tal como han existido y siguen existiendo) resultará ser una filosofía irracionalista, que desprecia el respeto por los hechos y la consistencia. Una filosofía contra la ciencia resulta ser anticientífica. Este tipo de posturas son las que alimentan doctrinas como las del fundamentalismo religioso, la tecnofobia y el activismo contra la investigación y aplicación científica. Quien filosofa contra la ciencia, o aun al margen de ella, ignorándola por completo (tal como nos dice Bunge) imita a los escolásticos que rehusaban mirar por el anteojo astronómico de Galileo.

Si hablamos de una filosofía sobre la ciencia estamos haciendo referencia a una disciplina superior rectora de las disciplinas científicas. Aunque éste ha sido el anhelo de muchos que en el pasado se han llamado a sí mismos "epistemólogos", lo cierto es que estos intentos no han sido otra cosa más que la burla de los científicos, pues siempre han mostrado grados intolerables de arrogancia combinados con ignorancia científica. Si quieres hacer que la comunidad científica se burle de la filosofía y la desprecie, tan sólo di que la filosofía es superior a la ciencia y que la primera le dice cómo actuar a la segunda.

Por otro lado, la expresión filosofía bajo la ciencia sugiera una posición inversa, como si la filosofía dependiera de forma absoluta de la ciencia. Este error, aunque poco común entre los filósofos que miran sus propuestas casi siempre como superiores a los anteriores, suele ser expresado como una virtud epistemológica. Sin embargo, la filosofía de la ciencia no sólo comporta el examen de los supuestos filosóficos de la investigación científica, sino que tiene derecho a una elaboración creadora de un nivel diferente del científico aunque reposa sobre éste último: el nivel metacientífico.

La comprensión precisa de la epistemología como la principal disciplina filosófica que, estando al margen de la ciencia, la cuestiona, la crítica y la analiza como la manifestación humana que es, probablemente sea el primer paso para comprender la relación tan estrecha entre filosofía y ciencia. Algo importante a comprender es que no todo el que tiene título en filosofía es un epistemólogo, del mismo modo que el no tener título en filosofía no significa que no se sea (o no se pueda ser) epistemólogo. Existen filósofos con perspectiva científica y científicos con inquietudes filosóficas que enriquecen por igual esta disciplina fascinante. Un segundo paso para este mismo propósito sería hablar de los logros e importancia de la epistemología para con la investigación, la aplicación y la divulgación de la ciencia, pero eso ya será tema para otra entrada.

*Publicación original en La pipa de Russell.

Acerca del Autor:

Daniel Galarza Santiago es estudiante de filosofía en el Centro Universitario de Ciencias Sociales y Humanidades (CUCSH) de la Universidad de Guadalajara. Autor de los blogs El escéptico de Jalisco y La pipa de Russell, también ha colaborado en otros espacios en línea tales como Blog Escéptico, Despertando Mentes, Magufobusters, Escépticos Unidos Mexicanos y Fundación Richard Dawkins para la Razón y la Ciencia.

100,000 Strong in the Americas, ¿qué podemos esperar?

“When we study together, we learn together, we work together and we prosper together.” President Barack Obama, May 2013, Mexico City.

“Cuando estudiamos juntos, aprendemos juntos, trabajamos juntos y prosperamos juntos.” Presidente Barack Obama, Mayo 2013, Ciudad de México.

Históricamente la relación entre los Estados Unidos Mexicanos y los Estados Unidos de América ha sido compleja y ha estado moldeada por lazos políticos, de negocios, culturales y familiares. El intercambio demográfico actual en la región es tan grande que la población hispana de los Estados Unidos de América ha superado los 50 millones de personas, haciéndolo el país con más hispanohablantes después de México. Sin embargo, intercambio demográfico no necesariamente significa un óptimo intercambio cultural e ideológico y aún hay un gran trabajo conjunto por hacer para impulsar la cooperatividad y el crecimiento en la región.

En la visita más reciente del Presidente Barack Obama a nuestro país, un tema importante en la agenda de discusión fue el programa 100,000 Strong in the Americas (100,000 Fuertes en las Américas), cuyo propósito principal es impulsar la movilidad de estudiantes no sólo entre los Estados Unidos de América y México, sino en todo el continente. Este programa pretende atraer a 100,000 estudiantes latinoamericanos a estudiar en EUA, mientras 100,000 estudiantes estadounidenses van a estudiar a Latinoamérica anualmente, con el objetivo final de lograr una mejor integración social, cultural y comercial en el continente. Este programa será financiado por el Gobierno de los Estados Unidos de América, la Asociación de Educadores Internacionales (NAFSA), gobiernos de países latinoamericanos, universidades y el sector privado.

¿Por qué es necesario un plan como este? La población del continente americano alcanza cerca de los 1,000 millones de habitantes (México: ~120 millones; Estados Unidos de América: ~300 millones) y se proyecta que para 2050 la población del continente rebase los 1,250 millones. Este crecimiento demográfico demanda soluciones innovadoras a problemas en sectores como salud, medio ambiente, educación, migración, seguridad, entre otros.

Actualmente existen diversos esfuerzos por crear soluciones a los problemas conjuntos de las Américas, pero a pesar de la cercanía geográfica aún hay grandes puentes que tender para lograr un entendimiento más profundo de la diversidad cultural. Esta vasta diversidad ideológica y cultural enriquece al continente pero al mismo tiempo hace que sea complicado crear políticas que funcionen y sean efectivas en toda la región. Estas soluciones sólo serán producto de trabajo en equipo entre los futuros líderes e innovadores de las naciones americanas. Facilitar el intercambio académico y cultural entre estos jóvenes futuros líderes los ayudará a comprender de manera más integral estos problemas, compartir ideas y crear soluciones para los mismos.

Sin duda las áreas de ciencia, tecnología, ingeniería y matemáticas (las famosas áreas “STEM” por sus siglas en inglés: science, technology, engineering and mathematics) serán de vital importancia en este programa y para el futuro desarrollo del continente.

¿Quién se beneficiará de un programa como este? En el corto plazo, los jóvenes estudiantes. La experiencia de estudiar en el extranjero crea una nueva forma de percibir tus raíces, un sentido de responsabilidad por volver a casa y ayudar a quienes están ahí. En el mediano y largo plazo: los países participantes en este programa, pues habrá una red de profesionales pensando en los problemas de estos países desde una perspectiva global, con ideas provenientes de todo el continente, buscando la manera de colaborar para crecer juntos. Se espera que el intercambio comercial en América crezca como resultado de esta iniciativa y de esta forma el sector privado también resultaría beneficiado, impulsando el crecimiento económico del continente.

Este intercambio académico traerá consigo intercambio de ideas e impulsará la cooperación. Los lazos de amistad creados a partir de la movilidad de estudiantes dentro del continente fortalecerán los lazos humanos en las Américas, sin duda indispensables para el crecimiento de nuestro continente. Durante la etapa de estudios universitarios se crea una manera de pensar y abordar problemas, la movilidad estudiantil creará una mente multicultural entre los estudiantes de las Américas, se fomentarán amistades entre personas de diferentes países, estos lazos traerán un mayor intercambio comercial, cultural y de valores para el continente.

¿Qué debe hacer México? Creo que la respuesta es simple, hacer lo que nos corresponde de la mejor manera. Si eres estudiante: estudia; en México o en el extranjero, donde estés hazlo lo mejor posible, no hay más. A los líderes políticos, apoyar e impulsar programas como este, facilitar los medios para que más estudiantes mexicanos se beneficien de esta iniciativa. Los profesores y académicos, mejorar su desempeño día a día para que las institutions educativas mexicanas sean más atractivas para estudiantes no sólo de Estados Unidos y Latinoamérica, sino de todo el mundo, de esta forma el intercambio académico y cultural será continuado así como los beneficios que lo acompañan.

Si la población hispana en los Estados Unidos actualmente es de más de 50 millones de personas, ¿podrán 100,000 estudiantes latinoamericanos impactar en la forma en que EUA mira a Latinoamérica? Y si la población de toda América es de casi 1,000 millones de personas, ¿podrán 200,000 jóvenes estadounidenses y latinoamericanos mejorar la calidad de vida y proponer soluciones a los grandes problemas del continente? El reto es grande, pero también lo son el liderazgo, la pasión y el talento de los jóvenes de las Américas.

Escrito por Jorge Buendía y publicado originalmente en AILUM

[hozbreak]

Acerca del autor

Jorge Eduardo Buendía Buendía es egresado de la Licenciatura en Ciencias Genómicas de la UNAM y actualmente investigador asistente en la Universidad de Edimburgo. Es también co-fundador de la Asociación de Ingenieros Líderes Unidos por México A.C. Sus intereses académicos yacen en la intersección entre matemáticas, computación y biología. De manera paralela se interesa en temas como educación, salud pública y literatura.

¿Comer por dos en el embarazo?

Mi abuela decía que echando a perder se aprende y yo lo viví echando a perder mis codos cuando estaba tratando de aprender a andar en bicicleta. Al final sólo me quedaron unas cicatrices y no pasó a mayores, pero a mi tía Karina no le fue tan bien. Cuando Manuelito nació, todos estábamos encantados. ¡Pesaba más de cuatro kilos! Era increíble. Sobre todo considerando que en la familia somos más bien menuditos.

Se veía tan grande y gordo que nos pareció muy extraño que tuviera que quedarse en el hospital. Aparentemente no respiraba bien. En una de las visitas que le hicimos, el doctor nos explicó que la tía Karina había cursado con diabetes gestacional y que por eso Manuelito había nacido tan grande y estaba teniendo problemas para respirar. Nos dijo que se le había quedado líquido en los pulmones y tendría que estar en observación unos días.

Foto: Teresa Rodríguez

Una adecuada alimentación durante el embarazo es crucial tanto para la madre como para el bebé que está por nacer. Al planear un embarazo con asesoría nutricional es posible corregir las deficiencias y excesos en la alimentación de la futura madre que pudieran representar un riesgo para ella o para el feto.

Foto: radloff

Para las mujeres embarazadas es común escuchar la frase “estás comiendo por dos”. La dicen en películas, en libros y en ocasiones hasta las mamás y las abuelitas. Sin embargo, durante los tres primeros meses de gestación, una dieta equilibrada, tal como la que debe llevar cualquier otra persona, es suficiente para cubrir los requerimientos tanto de la madre como del producto. Es importante aumentar el consumo de agua (en la medida que lo recomiende el médico o nutriólogo) para contribuir a la formación del líquido amniótico, el cual rodea al bebé durante el embarazo.

En el tercer trimestre del embarazo se pueden suplementar alrededor de 500kcal adicionales al requerimiento normal, vigilando siempre la calidad sobre la cantidad. Esto implica consumir alimentos que contengan proteínas de buena calidad (como carnes y leguminosas), ácidos grasos esenciales (como pescado graso y nueces) y frutas y verduras, llevando una dieta variada y suficiente. Es importante evitar la comida rápida (frita y con alimentos en conserva o congelados), los alimentos ricos en sal y el exceso de grasa y azúcares en la dieta. Una regla no escrita es que la madre debe haber ganado un total de 10 kilos al término del embarazo. En general, puede ser un buen dato a tener en mente, pero claramente depende del caso, ya que no todas las personas inician su embarazo en las mismas condiciones ni con el mismo peso. Por ejemplo, para personas que inician el embarazo con sobrepeso, este rango normalmente se reduce de 5-9 kg. En el 2008 se publicó un reporte en Estados Unidos con el fin de ayudar a médicos y nutriólogos a proporcionar una mejor asesoría respecto a este tema durante el embarazo y evitar el uso de esa “regla de dedo”.

La diabetes gestacional es uno de los posibles problemas que pueden surgir durante el embarazo. Están en riesgo, principalmente las personas mayores de 25 años, con sobrepeso o con antecedentes diabéticos en la familia. Actualmente, desconocemos el porcentaje exacto de la población que sufre este padecimiento, pero el número de casos reportados ha aumentado en los últimos años.

El detectar este padecimiento en etapas tempranas permite que la mujer gestante reciba el tratamiento adecuado para reducir al mínimo los riesgos asociados al mismo. Estos riesgos incluyen hipertensión arterial, preclampsia y eclampsia en la madre. Mientras que en el bebé puede causar un tamaño demasiado grande o demasiado pequeño, complicaciones respiratorias e ictericia, entre otros problemas. El llevar un buen control de peso y nutricional es crucial para prevenir este padecimiento durante el embarazo.

A mamá le extrañó mucho que eso fuera lo que tenía la tía Karina. Ella me dijo que la diabetes más bien le da a personas mayores o que consumen mucha azúcar.

La diabetes gestacional no siempre se presenta a causa de sobrepeso, de hecho, parece estar asociada a las hormonas placentarias que pueden llegar a bloquear los efectos de la insulina en el cuerpo de la madre. Esto hace que no haya suficiente insulina para transportar la glucosa a las células y convertirla en energía, causando así diabetes. Algunos de los síntomas incluyen visión borrosa, mareos, vómito y sed, entre otros. Todo esto puede evitarse con una adecuada alimentación.

Mientras Manuelito seguía en el hospital, mamá y yo nos quedamos con la tía Karina. Ella se sentía muy cansada todo el tiempo y siempre tenía sed. Al parecer así había pasado todo el embarazo. No sólo eso, también había tenido muchos “ascos” y de repente veía borroso.

En la actualidad es común que las mujeres embarazadas, sobre todo las adolescentes, tengan miedo de engordar y por ello busquen comer lo menos posible durante el embarazo. Cuando las ratonas preñadas, son alimentadas con una dieta pobre en proteínas se han observado problemas en el desarrollo del cerebro y páncreas del feto.

El embarazo adolescente y los embarazos espaciados por menos de un año son situaciones donde el cuerpo de la madre puede presentar mayores deficiencias. El embarazo en adolescentes es un tema muy delicado ya que, en muchos casos, la futura madre sigue creciendo; este crecimiento provoca una competencia por recursos con el feto en desarrollo, lo cual puede traer consecuencias como bajo peso al nacer o partos prematuros. La solución no es tan simple como alimentar más a la madre, ya que es fácil que al comer más, la chica aumente de peso mucho más de lo recomendado. No es una cuestión de cantidad, sino de hacer lo posible por cumplir con las necesidades tanto de la madre como del producto. Si la madre ya tiene una deficiencia nutricional importante, el cuerpo suele darle preferencia a la madre, mientras que cuando la alimentación es ligeramente deficiente, el cuerpo de la madre favorece al feto.

En los últimos años se han llevado a cabo diversas campañas para fomentar que las mujeres embarazadas consuman nutrientes como el ácido fólico. Esto es debido a que bajos niveles de hierro y de ácido fólico durante la gestación pueden llevar a partos prematuros y retraso en el crecimiento del feto. A pesar de que el mecanismo exacto en que actúa el ácido fólico se desconoce, hay evidencia de su importancia para disminuir la incidencia de malformaciones como la espina bífida.

La espina bífida es una malformación de los tejidos neurológicos. No es la única, pero es la más común. En ella, la columna vertebral de los bebés no cierra adecuadamente y frecuentemente es necesario operarla para evitar que el daño empeore. Esto hace muy importante el llevar una dieta adecuada durante la gestación y consumir suplementos cuando así sea requerido.

Foto (modificada): Thomas Hellberg

A la tía Karina la trataron con una dieta restrictiva y Manuelito, no tardó en salir del hospital. El doctor le dijo a mamá que, a pesar de las complicaciones, Manuelito ya estaba bien y fuera de peligro. Le comentó que en muchos casos, después de sufrir diabetes gestacional, una persona puede volverse diabética, por lo que la tía Karina debería ir a revisiones periódicas para hacer lo posible para evitar que la diabetes se consolidara.

[hozbreak]

Bibliografía

En “Diabetes gestacional. Comportamiento de los factores de riesgo en población mexicana” los autores revisaron los principales factores de riesgo para esta enfermedad en México.

Aquí pueden encontrar la liga acerca de la alimentación en madres adolescentes, así como el aumento de peso recomendado en ellas.

Guía general (revisada por médicos) de las necesidades nutricionales de la mujer embarazada. En ella se mecionan los aumentos de peso durante el embarazo que suelen recomendarse. En Outcomes of Maternal Weight Gain se realizó una revisión de la literatura con el fin de orientar la atención médica y nutricional de mujeres embarazadas con respecto a su peso.

Estudio sobre la resistencia a insulina en ratones tratados con placenta humana.

En “Influences of pre- and postnatal nutritional exposures on vascular/endocrine systems in animals” se menciona los efectos que una dieta pobre en proteínas puede tener en el desarrollo del páncreas de ratones.

Los autores de "Early life protein restriction alters dopamine circuitry" y "Early protein malnutrition disrupts cerebellar development and impairs motor coordination" argumentan que una dieta pobre en proteínas puede causar un desarrollo deficiente del sistema nervioso.

En Recommendations for Weight Gain During Pregnancy in the Context of the Obesity Epidemic se mencionan algunas recomendaciones para el control de peso y alimentación durante el embarazo de personas con sobrepeso.

En el artículo de revisión: Diabetes mellitus gestacional. Puede encontrarse información acerca de las causas y posibles consecuencias de la diabetes gestacional.

En el artículo The Risk of Maternal Nutritional Depletion and Poor Outcomes Increases in Early or Closely Spaced Pregnancies, los autores mencionan cómo el tener embarazos consecutivos y una mala nutrición pueden afectar tanto al feto como a la madre.

[hozbreak]

Acerca del autor

Libertad Pantoja Hernández nació en la Ciudad de México. Estudió Ciencias Genómicas en el campus Morelos de la UNAM. En el 2008 y 2009 participó el concurso iGEM de máquinas genéticas. Actualmente estudia el Doctorado en Ciencias Biomédicas en la UNAM y participa en el Taller de Narrativa impartido por Alberto Chimal. Cada vez que puede escribe y dibuja.

No todo es lo que parece. Agallas, manzanas de roble e insectos.

Vas de excursión, caminando en medio del bosque. Ya pasaron unas horas desde que te comiste tu último sándwich y desapareciste la última manzana. Ves una fruta redonda, rojiza y que parece estar cubierta de pelos. Está en medio de las rosas silvestres, lo cual te parece curioso. De cualquier modo, de inmediato piensas que ha de ser algo similar al rambután. Esa fruta dulce parecida a los lichis. No parece haber nada más a la redonda y, dado que llevas un rato sin comer, suena a una buena botana. Tomas tu navaja y la partes a la mitad antes de pelarla. Entonces ves algo que de inmediato te quita el hambre. Sucede que la fruta que tomaste no es tal y un gusanito blanco te observa pasmado desde su interior.

Ilustración 1. Agalla causada por una avispa Diplolepis. Fotografiada por J.R. Crellin.

Las agallas (fitomas, cedidios o abogallas) son estructuras inducidas en las plantas por la presencia de un organismo extraño como puede ser un insecto, bacteria o virus. Algunas se ven tan sólo como pequeñas protuberancias en las hojas.

Ilustración 2. Diplolepis rosae en Rosa canina. Tomada el 25 de agosto de 2007 por Frank Vincentz.

En inglés se les denomina gallnuts (nueces de bilis) o insect-galls (bilis de insecto) debido al sabor amargo característico de los taninos que contienen, los cuales son sustancias amargas producidas por las plantas que precipitan proteínas. La existencia de estos taninos permitió que antiguamente las agallas se emplearan para curtir pieles. En la edad media se utilizaron como fármacos y se les atribuían propiedades adivinatorias. Se creía que el año dependería de si dentro de la agalla se encontraba un gusano, una mosca o una araña. Si había un gusano habría hambre, si era una mosca guerra y si era una araña pestilencia. También fueron utilizadas para la elaboración de colorantes y tinta. En el este de África las mujeres somalíes utilizaban un tipo de agalla para realizar tatuajes. ¡Incluso llegaron a usarse para alimentar al ganado!

Es común que los árboles de aguacate se infecten de Trioza, un insecto cuyas ninfas (un estado anterior al adulto) viven en agallas en las hojas de aguacate. Por su aspecto, es claro que estas agallas son un elemento extraño en la planta; sin embargo, hay algunas que tienen un aspecto tan similar al de las frutas o brotes de hojas que son casi indistinguibles de las estructuras normales de las plantas. Tal es el caso de las “manzanas de roble”, que son agallas dentro de las cuales crecen las larvas de una especie de avispa llamada Amphibolips confluenta. En México, éstas suelen verse también en los encinos y llegan a alcanzar ocho centímetros de diámetro. Aunque no tienen precisamente la misma forma de las manzanas, su color rojizo o amarillento hace que se confundan fácilmente con frutos.

Ilustración 3. Manzana de Roble producida por Trichoteras vaccinifoliae. Fotografiada por Ron Russo para Confessions of a Gall Hunter en la Revista de Historia Natural (Natural History Magazine).

De acuerdo con Margaret M. Fagan, las agallas causadas por Discholcaspis weldi (una especie de avispa) en Quercus reticulata (un roble) podían adquirirse en puestos de frutas de la Ciudad de México.

Las agallas a las que nos referimos en el inicio de este texto han sido llamadas Diplolepis bicolor y son causadas en las rosas por otro tipo de avispas. Estas son comunes en Canadá y Estados Unidos, donde frecuentemente son fotografiadas por excursionistas.

Debido a sus propiedades, a lo inesperado que resulta hallar un insecto viviendo dentro de una “frutilla” y a la variedad de formas que pueden generar (más allá de los vistosos cuasi-frutos), las agallas han despertado el interés de la comunidad científica desde hace muchos años. Inicialmente interesaba medir cómo afectan las agallas el crecimiento y rendimiento de las plantas. En algunos trabajos sobre fósiles de agallas, se les han calculado edades de más de 300 millones de años, lo cual nos habla de lo antigua que es esta relación entre las plantas y los insectos.

A pesar del tiempo que llevan estudiándose, los mecanismos moleculares por los cuales los insectos logran controlar el desarrollo de las plantas para formar estas intrincadas estructuras, aún son un misterio. Se saben, y en algunos casos se sospechan, cuáles podrían ser algunas de las moléculas involucradas en estos procesos, pero aún hay mucho por averiguar. En principio, llama la atención que unos cuantos cambios, como mordeduras de los insectos y las sustancias que el insecto le transmite a la planta por medio de su saliva, puedan generar este tipo de respuesta. Ante la presencia de estrés, algunas células de las plantas cambian de un tipo celular a otro para reparar y neutralizar los cambios. Pero si el estímulo es muy fuerte, la planta suele matar a las células bajo la influencia del insecto u otro parásito para asegurar la supervivencia del resto del organismo.

Sabemos que hay pasos clave para que los insectos consigan formar una agalla completa, como el reconocimiento de la llegada del insecto por parte de la planta, la señalización que se da dentro de la planta después de reconocer esta llegada, el crecimiento de la agalla y la diferenciación observable. De momento, como se mencionó anteriormente, una pieza clave parece ser la saliva. Científicos que estudian este tema proponen que la saliva genera un “choque” químico que altera el estado de las células generando el estrés que lleva a la célula a cambiar de tipo celular en un intento por compensar los daños. Incluso los mismos compuestos dentro de la célula, al ser expulsados cuando la planta es mordida por un insecto, podrían ser los que estén induciendo el estrés que es clave en el inicio de la formación de una agalla.

Las agallas reciben una gran cantidad de señales bioquímicas provenientes de las hojas sobre las que crecen. Por lo general, dichas señales ayudan a que una hoja se desarrolle normalmente, pero las agallas logran diferenciarse independientemente de estas señales, desarrollando estructuras impresionantes.

Las plantas no son los únicos organismos que pueden verse afectados por avispas, ya que estos insectos también pueden inducir comportamientos extraños en arañas, cucarachas y otros organismos que parasitan. Algunos investigadores han comparado este comportamiento con un estado “zombie”, que lleva al ser infectado a suicidarse o dejarse llevar ciegamente por su captor. Llama mucho la atención ya que otras presas, como las mariposas, sólo son paralizadas y no exhiben estos cambios de comportamiento. En las cucarachas, las avispas logran imponer su control por medio de un “cóctel” neurotóxico que suprime la actividad de algunas neuronas, cambiando así la “motivación” de la cucaracha por caminar. Con esta acción la avispa impide que la cucaracha escape del nido donde la avispa la coloca. Este es otro ejemplo de una respuesta extraña y compleja lograda con una señal sencilla.

Además de ser procesos por sí mismos muy interesantes, el estudio de la formación de estos brotes falsos conocidos como agallas y el control que ejercen las avispas sobre el sistema nervioso de otros organismos, ayuda a entender cómo se dan otros procesos como la diferenciación y simetría en las plantas.

[hozbreak]

Bibliografía y literatura adicional

Agallas sobre Quercíneas es un documento en español del 2006 de la Universidad de Aragón, revisado por los Doctores Pedro del Estal, José Luís Nieves-Aldrey y Juli Pujade-Villar. Este documento contiene una breve introducción acerca de las agallas, en donde se comenta, a grandes rasgos, cómo actúan algunos insectos inductores de agallas.

On predatory wasps and zombie cockroaches: Investigations of “free will” and spontaneous behavior in insects, es una revisión donde Ram Gal y Frederic Libersat discuten cómo se da el control mental de las avispas hacia las cucarachas.

Fossil oak galls preserve ancient multitrophic interactions de Graham N. Stone y sus colaboradores es un artículo del 2008 en donde los autores describen un fósil de agallas. Lo interesante del artículo es que, a pesar de haber evidencia fósil previa, este espécimen está muy bien conservado y es muy detallado.

En The Effects of Stem Gall Insects on Life History Patterns in Solidago canadensis de David C. Hartnett y Warren G. Abrahamson (1979), los autores hicieron una exploración acerca de los posibles efectos de las agallas en las poblaciones de plantas.

The Uses of Insect Galls de Margaret M. Fagan (1918) es, a pesar de ser un artículo antiguo, una revisión muy interesante de los usos que los seres humanos le habíamos dado hasta ese entonces a las agallas de insectos y de cómo hemos ido comprendiendo su naturaleza.

Morphogenesis of insect-induced plant galls: facts and questions, de Anantanarayanan Raman (2011) es una revisión que nos habla de las evidencias actuales de cómo funcionan las agallas de insectos y de qué falta por saber.

[hozbreak]

Acerca del autor

Libertad Pantoja Hernández nació en la Ciudad de México. Estudió Ciencias Genómicas en el campus Morelos de la UNAM. En el 2008 y 2009 participó el concurso iGEM de máquinas genéticas. Actualmente estudia el Doctorado en Ciencias Biomédicas en la UNAM y participa en el Taller de Narrativa impartido por Alberto Chimal. Cada vez que puede escribe y dibuja.

Cómo publicar un artículo de acceso libre en una revista de acceso restringido

Publicado originalmente en SVPOW por Mike Taylor.

Recientemente tuve una conversación con un amigo que está a punto de publicar su primer artículo. El artículo ya pasó las etapas de revisión y está aceptado en una revista de prestigio y de la vieja escuela. No es una revista de acceso libre (open-access, OA) y mi amigo me pidió consejos para saber cómo podría publicar el artículo bajo el esquema de acceso libre en esta revista.

Tuvimos una discusión fructífera y ambos estuvimos de acuerdo en que podría escribir las conclusiones de esa discusión en este blog.

Para publicar un artículo de acceso libre en una revista de acceso restringido existen varias opciones. La primera opción es pagarle a la editorial para que tu artículo sea de acceso libre. Esa es una opción legítima en las revistas “de acceso libre híbrido” (hybrid OA journals), las cuales en este momento son prácticamente todas las revistas de acceso restringido. Pero incluso cuando la revista te invita a hacerlo, no siempre es posible. En este caso, mi amigo no tiene fondos institucionales disponibles para este rubro y realmente no está en posición de pagar tres mil dólares de su propio bolsillo.

La segunda opción es escribir a la revista diciendo que seleccionaste la opción de acceso libre, pero dado que no tienes financiamiento institucional debes solicitar una exención del pago. ¿Funcionará esta opción? Es imposible decirlo a menos que lo intentes. Algunas revistas tienen una política de “no-hay-exención-de-pago”. Rayos, incluso algunas tienen una política de “siempre concedemos las exenciones, pero no las anunciamos”. Mi idea es que la mayoría no tienen una política al respecto, ninguna en absoluto, pero que los editores (quienes son investigadores en su mayoría) tenderán a ser empáticos y apoyarán tu caso. De cualquier manera, no pierdes nada con solicitar la exención de manera amable.

Si eso falla, la tercera opción es usar el addendum SPARC para autores. Al utilizar este instrumento legal (el cual está disponible gratuitamente), no transfieres los derechos de autor a la editorial -algo que la editorial usualmente requiere- sino que les otorgas un permiso de publicación no exclusivo (lo cual es lo único que necesitan). Esto te otorga la libertad de publicar legal y gratuitamente la versión revisada de tu artículo en cualquier otro sitio: en un portal institucional, en tu página web personal o en cualquier otro lugar. Yo nunca he utilizado este recurso pero he escuchado que es ampliamente aceptado.

Si la editorial es tan intransigente como para rechazar el addendum SPARC, la cuarta opción es dedicar tu manuscrito al dominio público, por ejemplo, publicando en arXiv con la declaración de dominio público de Creative Commons. Una vez que esto está hecho, devuelve la forma de cesión de derechos al editor, diciéndole que no hay derechos de autor que transferir. Las editoriales están acostumbradas a tratar con artículos que no tienen copyright, por ejemplo, cualquier cosa que sea autoría de empleados del gobierno federal de los Estados Unidos está en la categoría de “dominio público”. Sus formularios de derechos de autor usualmente incluyen una sección para declararla libre de derechos o del dominio público.

Finalmente, si por alguna razón todas las tácticas anteriores fallan (si la revista simplemente se rehúsa a otorgarte una exención del pago, no acepta el addendum SPARC y rechaza que el trabajo sea de dominio público a menos que sea escrito por trabajadores del gobierno estadounidense -y si a pesar de su evidente hostilidad hacia la ciencia estás aun interesado en que esa revista acepte tu artículo) entonces tienes una última opción: sigue adelante, cede los derechos, y entonces coloca la versión final en PDF en tu página web personal*. Técnicamente no tienes el derecho a hacerlo, pero históricamente nunca ha sido un problema. Se hace de manera rutinaria, especialmente por profesores de la vieja escuela a quienes nunca, ni por asomo, se les hubiera ocurrido que compartir su propio trabajo podría ser un problema.

Sólo para ser claros, no estoy promoviendo esta última opción. Las cuatro primeras opciones son mejores porque están en completo acuerdo con las leyes de propiedad intelectual. Pero cuando te enfrentas a una editorial que simplemente está determinada a prevenir que tu trabajo sea leído, entonces tienes que plantearte si estás más interesado en respetar el copyright o en hacer lo que es correcto. Esta es la situación con muchos de mis primeros artículos, cuando en mis estúpidos días de juventud cedía la propiedad intelectual a las editoriales sin siquiera pensar en ello. Habiéndome metido en eso, me parece que colocar tales artículos disponibles para el público de cualquier manera posible es la menos mala de todas las opciones. Actualmente, sin embargo, nunca escogería esa opción dado que publico mis artículos exclusivamente en revistas de acceso libre.

En resumen:

La opción cero, que no se discute aquí, es que mandes tu artículo a una revista de acceso libre. Así, ninguno de estos problemas hubiera surgido, pero si ya no estás en posición de hacerlo:

1. Si tienes los recursos, úsalos para pagar a la editorial de manera que tu artículo sea de acceso libre.

2. Solicita una exención del pago.

3. Usa el addendum SPARC para autores para mantener la propiedad intelectual sobre tus trabajos y otorga a la revista una licencia para publicarlos.

4. Haz que tu manuscrito sea del dominio público y dile a la editorial que no puedes transferirles la propiedad intelectual de tu trabajo porque no existe propiedad intelectual en ese trabajo.

5. Si todo lo demás falla, de todos modos, haz que el artículo sea accesible para todo el público*.

* Nota del traductor: El texto menciona explícitamente que publicar el artículo en una web institucional o personal sin permiso de la editorial no es técnicamente legal y Taylor no lo recomienda. Recientemente Elsevier, una de las editoriales más importantes de revistas académicas, emprendió acciones legales contra diversas instituciones por violaciones a los derechos de autor. Para más información leer esta nota.

Acerca del autor: Michael P. Taylor es investigador asociado en el Departamento de Ciencias de la Tierra de la Universidad de Bristol. Es un defensor y promotor del Open Access, Open Source y Open Data. Puedes encontrarlo en twitter como @MikeTaylor

Los anillos de un Centauro

En la mitología griega, los centauros son seres salvajes con el cuerpo y las piernas de caballo y la cabeza, brazos y torso de humano. Los centauros se asocian comúnmente con un comportamiento irracional y visceral, son animales supersticiosos y miran al cielo con frecuencia para determinar su destino de acuerdo con la posición de los objetos celestiales. Poco saben los centauros descritos por la mitología griega que allí mismo, en el cielo al que miran antes de tomar sus decisiones, existe un grupo de objetos bautizados en su honor. Hablando en términos astronómicos, los centauros son cuerpos celestes que orbitan alrededor del Sol entre las órbitas de Júpiter y Neptuno y cuyo comportamiento se parece a veces al de los asteroides y a veces al de los cometas (la naturaleza híbrida de los centauros griegos está presente). A diferencia de los planetas, los cuales tienen órbitas elípticas definidas, la órbita que siguen los centauros es errática, igual que el errático camino de los centauros mitológicos, debido a la influencia de la gravedad de los planetas.

Uno de los centauros mitológicos más importantes es Queirón, quien se distingue de sus congéneres por ser racional y sabio. Queirón tuvo por esposa a la ninfa Cariclo, quien le ayudó activamente en la educación de dos héroes griegos: Jasón y Aquiles. Y es de Cariclo de quien hablaremos en este blog.

Cariclo y Queirón son los dos centauros (astronómicos) de mayor tamaño conocidos hasta el momento, tienen un diámetro de 250 y 230 Km respectivamente. Comparado con nuestra Luna, Cariclo es aproximadamente 14 veces más pequeño y tarda 63.17 años en completar una vuelta alrededor del Sol. Cariclo fue descubierto en 1997 y durante este tiempo las observaciones realizadas a este centauro fueron desconcertantes, pues a veces se observa una disminución inusual en el brillo que refleja. Además, aunque ya se había detectado la presencia de hielo en este centauro, en algunas observaciones no se detectaba hielo por ningún lado. Cariclo era un misterio y un desafío para los astrónomos, pero esa historia acaba de dar un giro inesperado: un grupo multinacional formado por investigadores de más de diez países formaron una red de observación espacial compuesta por distintos telescopios para observar la ocultación de una estrella debido al paso de Cariclo. Las ocultaciones son fenómenos frecuentes y se refieren a la disminución del brillo de una estrella por el tránsito de un cuerpo opaco entre la estrella y el observador. En este caso se dispuso a una serie de telescopios localizados en América del Sur para observar la ocultación de la estrella UCAC4 248-108672. Los resultados que se obtuvieron fueron sorprendentes, pues además de la disminución del brillo que se esperaba debido al tránsito de Cariclo, se observaron otras cuatro disminuciones en el brillo de UCAC4.

La primera explicación que se puede ofrecer para este resultado es que Cariclo posee cuatro satélites, pero la disminución del brillo de la estrella debido a estos "satélites" sugeriría que existen dos pares de satélites idénticos y que además están perfectamente alineados con Cariclo, lo cual es una explicación muy poco probable. La segunda explicación, la cual es mucho más interesante y probable, es que Cariclo posee dos anillos similares a los que se conocen para Saturno. Hasta ahora, los anillos sólo se conocen para cuatro grandes planetas: Júpiter, Saturno, Urano y Neptuno y se creía que una condición para la formación de los anillos es que la masa del planeta al que orbitan fuera tan grande que por efecto de su gravedad lograra mantener en órbita alrededor de él a distintos objetos de diámetro minúsculo o incluso partículas de polvo estelar o hielo. Por ello el descubrimiento de los anillos alrededor de Cariclo resulta relevante, pues su tamaño y masa son muy pequeños y contradicen a nuestra idea de que los anillos sólo pueden formarse alrededor de gigantes gaseosos como Saturno. Los anillos de Cariclo poseen un ancho de 6.5 y 3.5 Km y han sido llamados Oiapoque y Chuí, nombre de dos ríos que cruzan Brasil, país de origen de Felipe Braga-Ribera quien es el líder del equipo que realizó el descubrimiento. La presencia de dos anillos, y más específicamente la distancia que separa a estos anillos, sugiere también que Cariclo posee un satélite pequeño, el cual podría actuar como luna "pastora" al confinar y definir a Oiapoque y Chuí.

Ahora bien, de acuerdo con las mediciones de la ocultación de UCAC4, también fue posible proponer que la inclinación de los anillos es tal que algunas veces lo vemos de frente y otras veces de canto. Si el hielo que se ha detectado en Cariclo está contenido en los anillos, esto explicaría por qué el brillo del centauro aumenta y disminuye gradualmente (en función de la inclinación relativa de los anillos respecto a nosotros) y por qué a veces detectamos el hielo y a veces no. Respecto a la formación de los anillos de Cariclo, se cree que son los restos de una colisión que sucedió a muy baja velocidad entre Cariclo y tal vez otro asteroide. Sabemos que si esta colisión ocurrió, debió ser a velocidades bajas porque un choque con mayor fuerza hubiese lanzado a los restos de la colisión lo suficientemente lejos para escapar del campo gravitacional del centauro, pues aunque es el más grande de los centauros observados hasta ahora, es realmente pequeño: tan sólo el lago Ontario, el menor de los grandes lagos Norteamérica, mide 300 Km de largo.

Además, el descubrimiento de los anillos de Cariclo nos ofrece la posibilidad de conocer nuestros orígenes, pues nos otorga la posibilidad de estudiar a las etapas primigenias de nuestro sistema solar, en el cual la nube de polvo y materia estelar, similar a la composición de los anillos de Cariclo, fue condensándose hasta formar a los planetas, incluido el nuestro.

Levanta los ojos al cielo nocturno, allá arriba, en un sitio lejano, los centauros siguen su rumbo errático y nos invitan a explorar misterios que esperan ser resueltos, ¿te animas a descubrirlos?

Acerca del autor:

Gustavo Rodríguez Alonso es estudiante del Doctorado en Ciencias Bioquímicas de la UNAM. Su proyecto está enfocado en el estudio de los genes que controlan el desarrollo de la raíz en las plantas cactáceas. Puedes encontrarlo en twitter como @RodAG_ o en su blog personal.